Im letzten Beitrag haben wir besprochen, was SnapLogic's Hadooplex mit Spark bieten kann. Nun wollen wir das Gespräch fortsetzen und sehen, welche Snaps für den Aufbau von Spark-Pipelines verfügbar sind.

Die im Spark-Modus verfügbaren Snaps ermöglichen es uns, Daten aus einem Hadoop-Ökosystem aufzunehmen und zu landen und die Daten zu transformieren, indem wir die parallelen Operationen wie Map, Filter, Reduce oder Join auf einem Resilient Distributed Datasets (RDD) nutzen, einer fehlertoleranten Sammlung von Elementen, die parallel bearbeitet werden können.

Es gibt verschiedene Formate für die Datenspeicherung in HDFS. Diese Dateiformate unterstützen ein oder mehrere Komprimierungsformate, die die Größe der im HDFS-Dateisystem gespeicherten Daten beeinflussen. Die Wahl der Dateiformate und der Komprimierung hängt von verschiedenen Faktoren ab, wie z. B. der gewünschten Leistung für bestimmte Lese- oder Schreibvorgänge und dem gewünschten Komprimierungsgrad für die Speicherung der Daten.

Die Snaps, die für den Ingestion und die Landung von Daten in der Spark-Pipeline zur Verfügung stehen, sind HDFS Writer, Parquet Writer, HDFS Reader, Sequence Parser, Parquet Reader und Sequence Formatter.

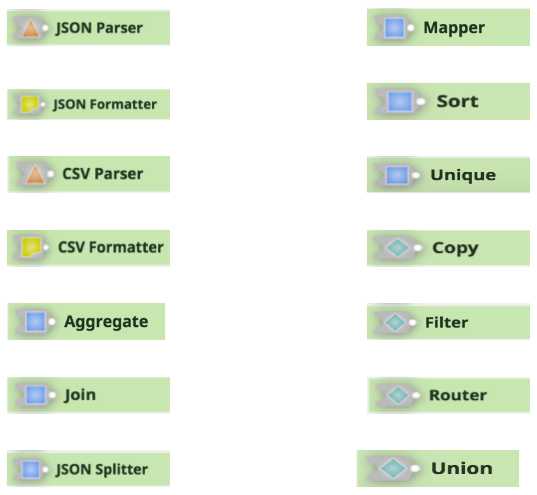

Die anderen Snaps in der Spark-Pipeline zur Unterstützung der Transformation und des Flusses von Daten sind JSON Parser, Mapper, JSON Formatter, Sort, CSV Parser, Unique, CSV Formatter, Copy, Aggregate, Filter, Join, Router, JSON Splitter und Union.

Erfahren Sie, wie Sie Spark-Pipelines für HDInsight erstellen und ausführen, sehen Sie sich eine SnapLogic Spark-Demo an oder kontaktieren Sie uns, wenn Sie weitere Informationen zu den SnapLogic-Lösungen für die Integration von Big Data erhalten möchten.