Dans l‘article précédent, nous avons discuté de ce que SnapLogic‘s Hadooplex peut offrir avec Spark. Poursuivons maintenant la conversation en voyant quels Snaps sont disponibles pour construire des pipelines Spark.

La suite de Snaps disponibles dans le mode Spark nous permet d‘ingérer et d‘atterrir des données à partir d‘un écosystème Hadoop et de transformer les données en tirant parti des opérations parallèles telles que map, filter, reduce ou join sur un Resilient Distributed Datasets (RDD), qui est une collection tolérante aux pannes d‘éléments qui peuvent être exploités en parallèle.

Différents formats sont disponibles pour le stockage des données dans HDFS. Ces formats de fichiers prennent en charge un ou plusieurs formats de compression qui affectent la taille des données stockées dans le système de fichiers HDFS. Le choix des formats de fichier et de la compression dépend de divers facteurs, tels que les performances souhaitées pour la lecture ou l‘écriture, le niveau de compression souhaité pour le stockage des données.

Les Snaps disponibles pour l‘ingestion et l‘atterrissage des données dans le pipeline Spark sont HDFS Writer, Parquet Writer, HDFS Reader, Sequence Parser, Parquet Reader et Sequence Formatter.

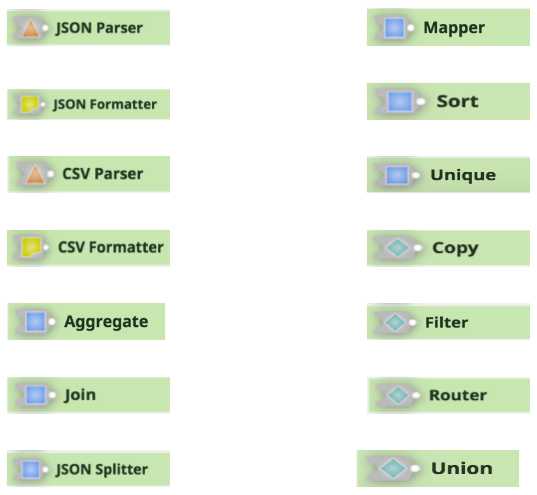

Les autres Snaps dans le pipeline Spark pour la prise en charge de la transformation et du flux de données sont JSON Parser, Mapper, JSON Formatter, Sort, CSV Parser, Unique, CSV Formatter, Copy, Aggregate, Filter, Join, Router, JSON Splitter et Union.

Vous pouvez apprendre comment construire et exécuter des pipelines Spark pour HDInsight, regarder une démo SnapLogic Spark, ou nous contacter pour plus d'informations sur les solutions d'intégration de big data Spark de SnapLogic.