Par Prasad Kona

Les organisations s'orientent de plus en plus vers les plateformes de données cloud et d'analysecloud telles que Microsoft Azure et les adoptent. Dans ce premier article d'une série d'articles de blog sur la plateforme de données Azure, je vais vous aider à faciliter l'adoption des plateformes cloud et l'intégration des données.

Dans ce billet, je me concentre sur l'ingestion de données dans Azure Cloud Data Platform et je montre comment lire et écrire des données dans Microsoft Azure Storage à l'aide de SnapLogic.

Pour ceux qui veulent se plonger dans le vif du sujet, ma vidéo étape par étape de 4 minutes "Building a simple pipeline to read and write data to Azure Blob storage" montre comment faire ce que vous voulez, sans écrire de code.

Qu'est-ce que le stockage Azure ?

Azure Storage vous permet de stocker des téraoctets de données pour prendre en charge des cas d'utilisation de données de petite ou de grande taille. Il est très évolutif, hautement disponible et peut traiter des millions de requêtes par seconde en moyenne. Azure Blob Storage est l'un des types de services fournis par Azure Storage.

Azure propose deux types de stockage pour les données non structurées : Azure Blob Storage et Azure Data Lake Store.

Stockage Azure Blob

Azure Blob Storage stocke des données objet non structurées. Un blob peut être n'importe quel type de texte ou de données binaires, comme un document ou un fichier multimédia. Le stockage Blob est également appelé stockage d'objets.

Azure Data Lake Store

Azure Data Lake Store offre ce que les entreprises recherchent aujourd'hui en matière de stockage et il :

- Il offre des fonctions de sécurité supplémentaires de niveau entreprise, telles que le cryptage, et utilise Azure Active Directory pour l'authentification et l'autorisation.

- Est compatible avec le système de fichiers distribués Hadoop (HDFS) et fonctionne avec l'écosystème Hadoop, y compris Azure HDInsight.

- Inclut les clusters Azure HDInsight, qui peuvent être provisionnés et configurés pour accéder directement aux données stockées dans Data Lake Store.

- Permet aux données stockées dans le Data Lake Store d'être facilement analysées à l'aide de cadres analytiques Hadoop tels que MapReduce, Spark ou Hive.

Comment transférer mes données vers Azure Data Platform ?

Voyons comment lire et écrire dans Azure Data Platform à l'aide de SnapLogic.

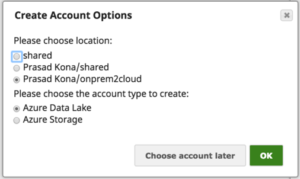

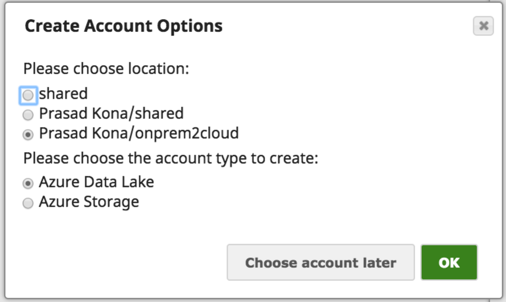

Pour les SnapLogic Snaps qui prennent en charge les comptes Azure, nous avons la possibilité de choisir entre Azure Storage Account et Azure Data Lake Store :

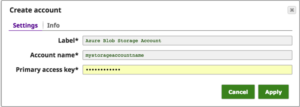

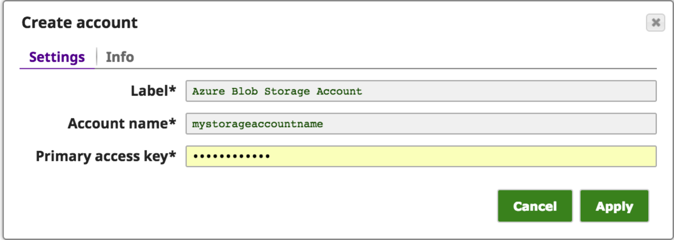

La configuration du compte de stockage Azure dans SnapLogic peut être effectuée comme indiqué ci-dessous en utilisant le nom du compte de stockage Azure et la clé d'accès que vous obtenez sur le portail Azure :

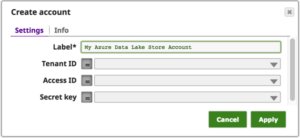

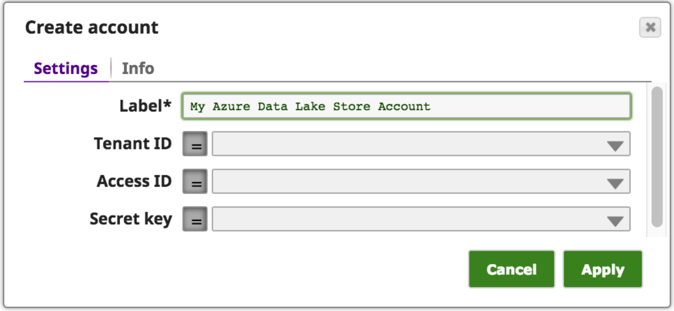

La configuration du compte Azure Data Lake Store dans SnapLogic, comme indiqué ci-dessous, utilise l'Azure Tenant ID, l'Access ID et la Secret Key que vous obtenez sur le portail Azure :

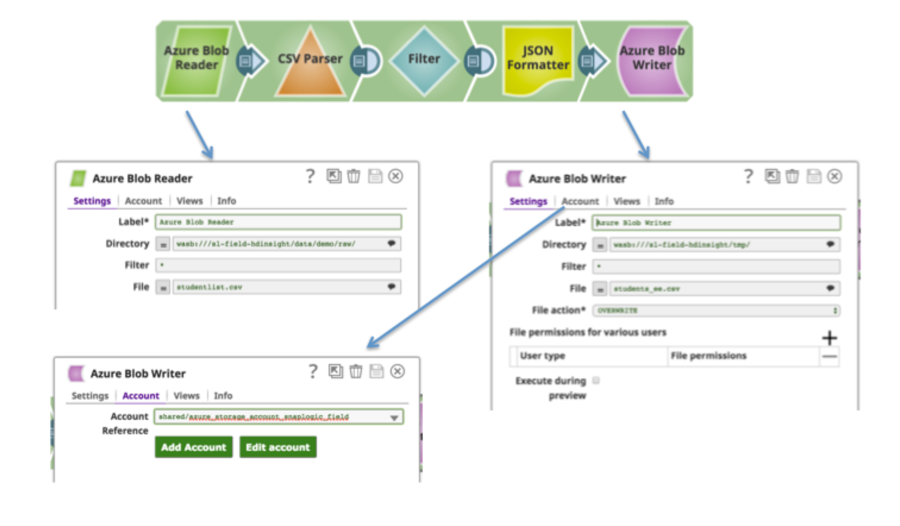

Ensemble, vous obtenez un pipeline simple qui illustre comment lire et écrire dans Azure Blob Storage :

Voici à nouveau la vidéo étape par étape : Construction d'un pipeline simple pour lire et écrire des données dans le stockage Azure BLOG

Dans mon prochain article de blog, je décrirai les approches permettant de déplacer les données de vos bases de données sur site vers Azure SQL Database.

Prasad Kona est architecte d'entreprise chez SnapLogic. Vous pouvez le suivre sur LinkedIn ou sur Twitter @prasadkona.