Dieser Leitfaden behandelt einige fortgeschrittene Techniken des Prompt Engineering und deren Anwendung im Snaplogic GenAI App Builder, damit Sie komplexere Aufgaben bewältigen und die Gesamtleistung verbessern können. Sie lernen, wie Sie System-Prompts verwenden, Antworten in JSON strukturieren, komplexe Prompts erstellen, Tokens verwalten und die Größe von Prompts und Kontexten berücksichtigen. Zunächst wollen wir uns darüber klar werden, was genau Prompt Engineering ist und warum es wichtig ist.

Was ist Prompt Engineering?

Im Kern geht es beim Prompt Engineering darum, die Eingabe (den „Prompt“) zu entwerfen, die Sie einem KI-Modell geben. Die Art und Weise, wie Sie Ihren Prompt formulieren, kann die Qualität und Relevanz der Ausgabe des Modells erheblich beeinflussen. Es geht nicht nur darum, was Sie von der KI verlangen, sondern auch darum, wie Sie es verlangen.

Warum ist Prompt Engineering wichtig?

Selbst die fortschrittlichsten KI-Modelle sind stark von den Eingabeaufforderungen abhängig, die sie erhalten. Eine gut formulierte Eingabeaufforderung kann zu aufschlussreichen, genauen und hochrelevanten Antworten führen, während eine schlecht strukturierte Eingabeaufforderung zu vagen, ungenauen oder irrelevanten Antworten führen kann. Das Verständnis der Feinheiten des Prompt Engineering kann Ihnen helfen, die Effektivität Ihrer KI-Anwendungen zu maximieren.

Voraussetzungen

- Grundlagen von Snaplogic

- OpenAI-, Azure OpenAI-, Amazon Bedrock Anthropic Claude- oder Google Gemini-Konto

Systemaufforderung

Die Systemaufforderung ist eine spezielle Eingabe, die das Verhalten, den Ton und die Grenzen des LLM definiert, bevor es mit Benutzern interagiert. Sie legt den Kontext fest und definiert die Regeln für Interaktionen, um sicherzustellen, dass die Antworten des Assistenten mit der gewünschten Persönlichkeit und den gewünschten Zielen übereinstimmen.

Stellen Sie sich vor, Sie sind Assistent in einem Reisebüro. Ihre Aufgabe ist es, Kunden maßgeschneiderte und präzise Reiseempfehlungen zu geben. Um dies effektiv zu tun, ist es wichtig, das Verhalten des LLM über die Systemaufforderung festzulegen: Definieren Sie die Rolle des Assistenten, legen Sie den geeigneten Ton und Stil fest und fügen Sie wichtige Anweisungen hinzu.

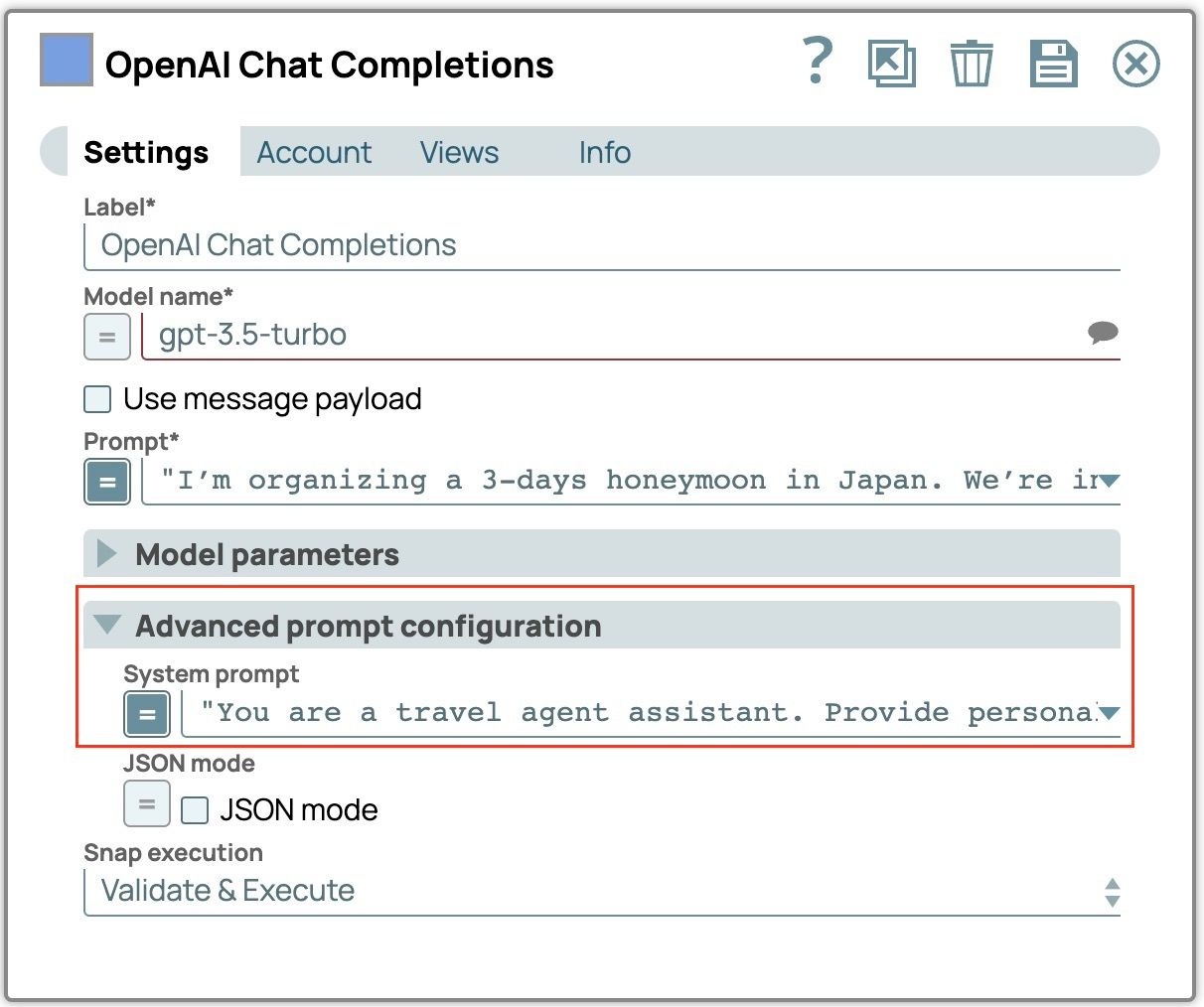

- Ziehen Sie „OpenAI Chat Completion“, „Azure OpenAI Chat Completion“, „Anthropic Claude on AWS Messages“ oder „Google Gemini Generate“ auf die Arbeitsfläche.

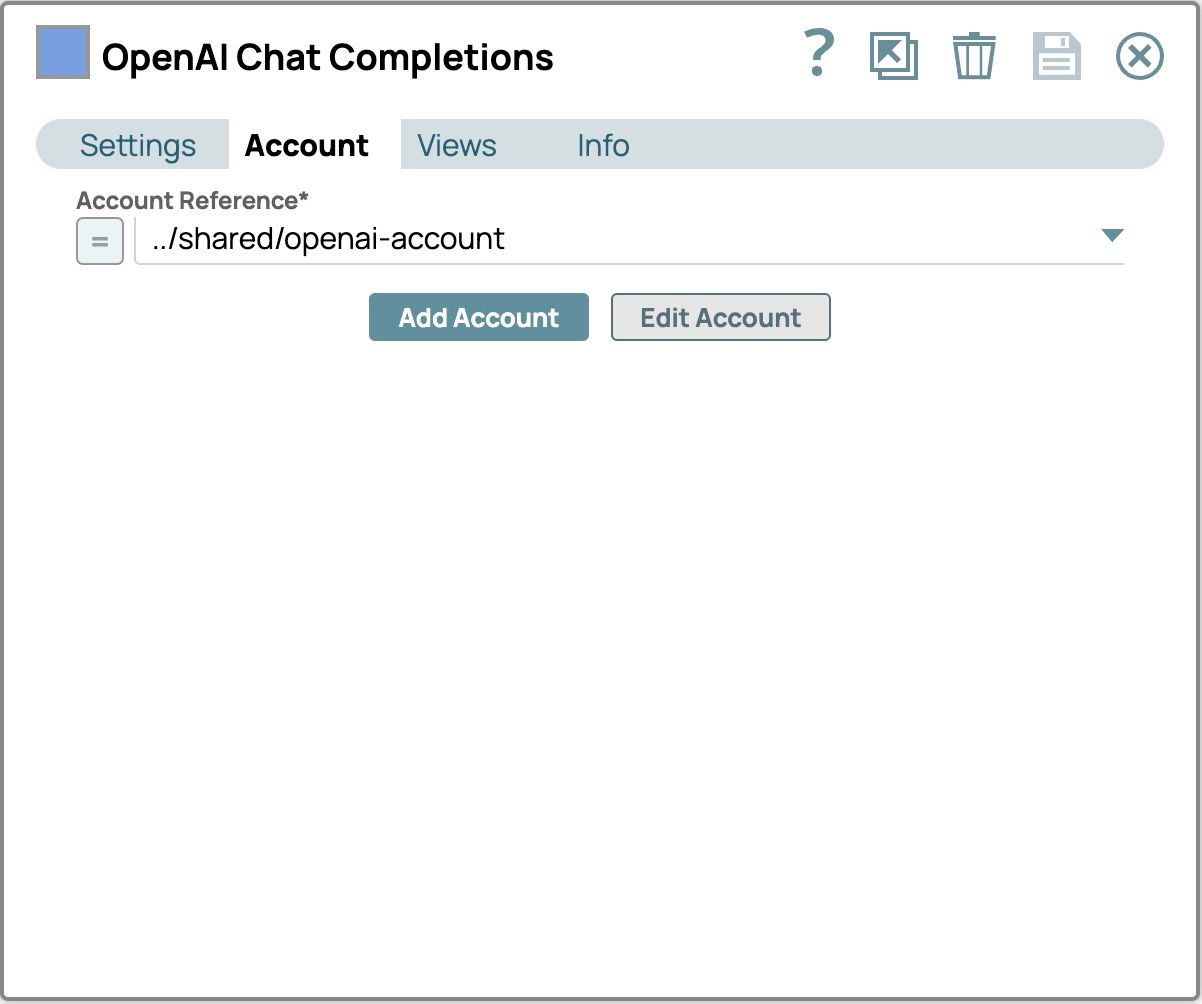

- Wählen Sie die Registerkarte „Konto“ und wählen Sie Ihr konfiguriertes Konto aus.

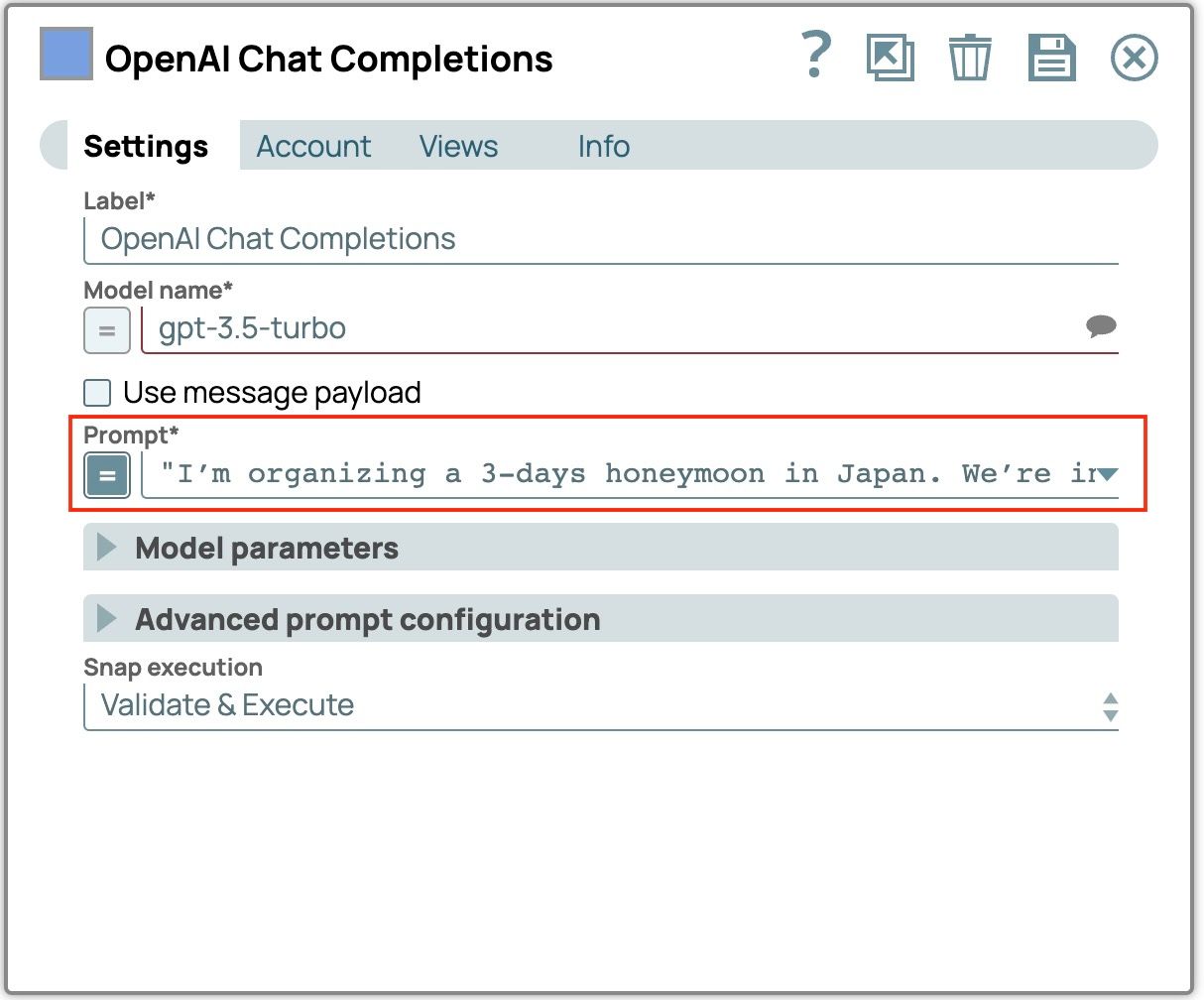

- Wählen Sie die Registerkarte „Einstellungen“, um diese Felder zu konfigurieren.

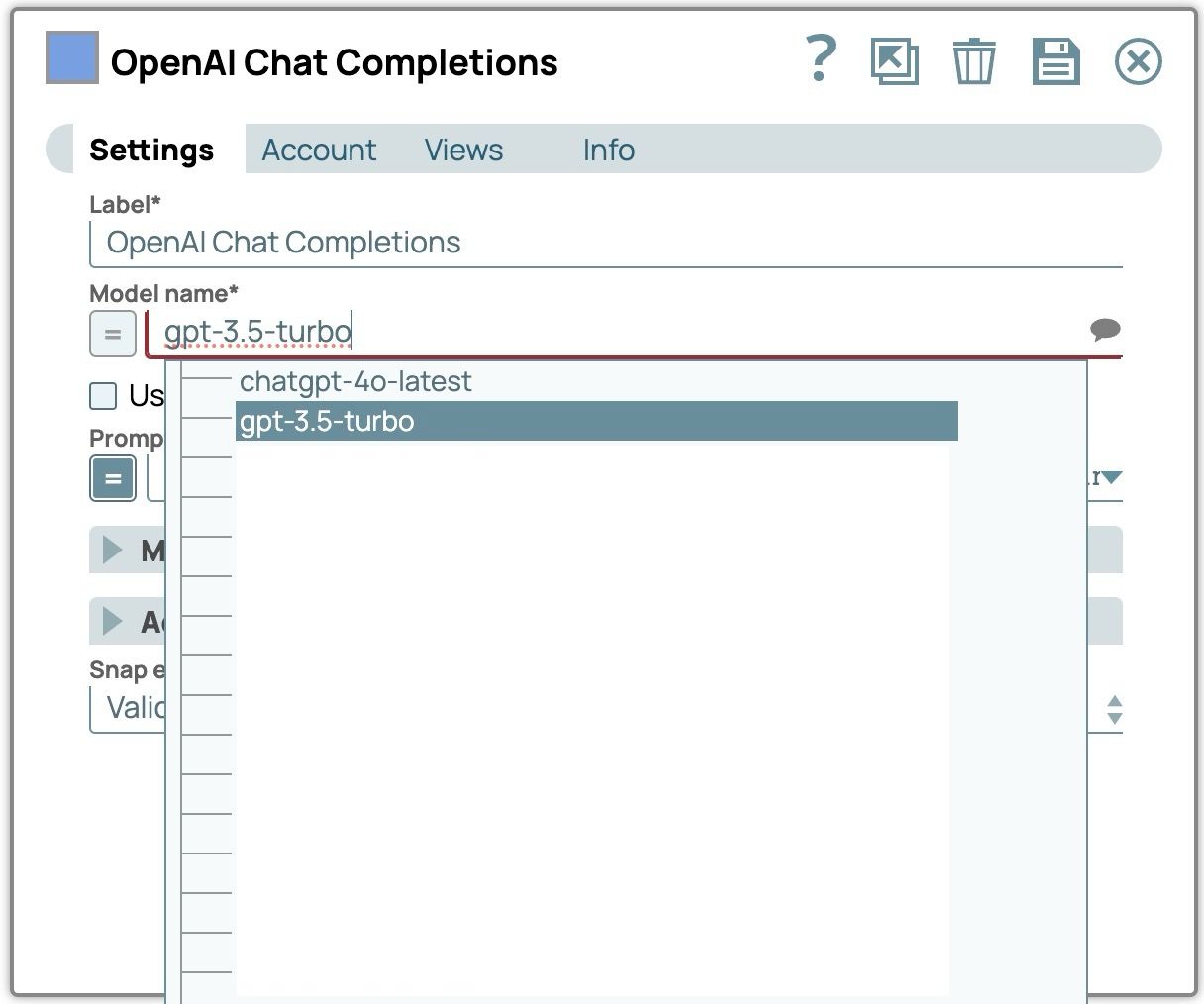

- Wählen Sie ein Modell ausKlicken Sie auf das Chat-Symbol, um die Liste der verfügbaren Modelle anzuzeigen und Ihr bevorzugtes Modell auszuwählen.

- „Eingabeaufforderung“ einstellen

„Ich organisiere eine dreitägige Hochzeitsreise nach Japan. Wir interessieren uns für kulturelle Erlebnisse und Natur.“

- „Systemaufforderung“ einstellen: Erweitern Sie die „Erweiterte Eingabeaufforderungskonfiguration“ und geben Sie die Systemeingabeaufforderung ein.

„Sie sind Assistent eines Reisebüros. Geben Sie personalisierte Reiseempfehlungen basierend auf den Präferenzen der Nutzer. Behalten Sie einen freundlichen und gesprächigen Ton bei. Wenn Sie nach Reiseplänen gefragt werden, beziehen Sie Unterkünfte und Restaurants mit ein.“

- Speichern und schließen Sie das Fenster mit den Snap-Einstellungen.

- Validieren Sie die Pipeline und sehen Sie sich das Ergebnis an, indem Sie auf die Vorschau der Datenausgabe klicken.

- Wählen Sie ein Modell ausKlicken Sie auf das Chat-Symbol, um die Liste der verfügbaren Modelle anzuzeigen und Ihr bevorzugtes Modell auszuwählen.

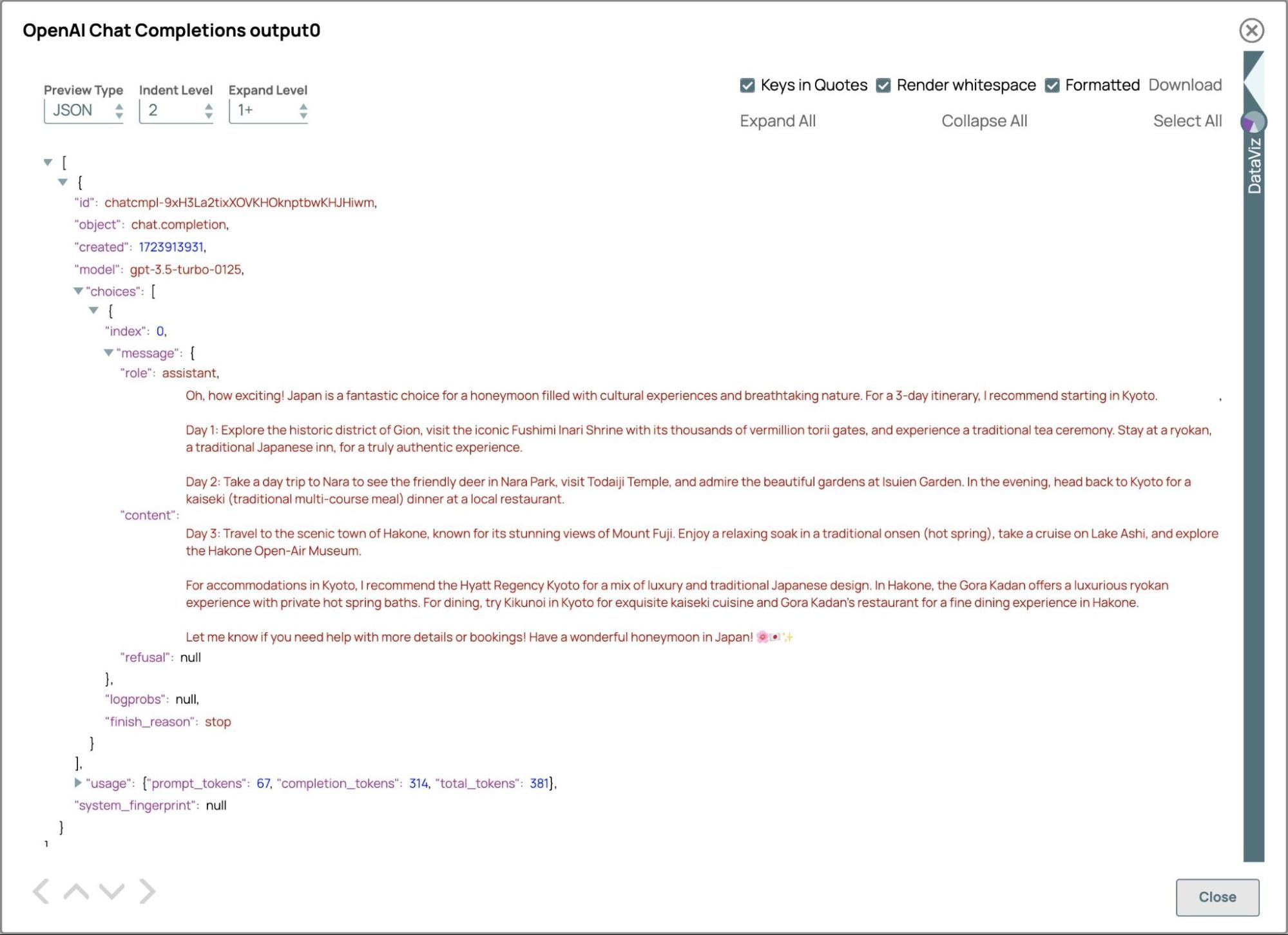

Zusammenfassung des obigen Beispiels

Systemaufforderung:

Sie sind Assistent/in eines Reisebüros.

Geben Sie personalisierte Reiseempfehlungen basierend auf den Präferenzen der Nutzer.

Behalten Sie einen freundlichen und gesprächigen Ton bei.

Wenn Sie nach Reiseplänen gefragt werden, beziehen Sie Unterkünfte und Restaurants mit ein.

Frage:

Ich organisiere eine dreitägige Hochzeitsreise nach Japan. Wir interessieren uns für kulturelle Erlebnisse und Natur.

Antwort:

Das ist ja aufregend! Japan ist das perfekte Reiseziel für eine Hochzeitsreise voller kultureller Erlebnisse und wunderschöner Landschaften.

Für Ihre dreitägige Reise empfehle ich Ihnen, in Kyoto zu beginnen, das für seine traditionellen Tempel und Gärten bekannt ist. Sie können berühmte Sehenswürdigkeiten wie den Fushimi-Inari-Schrein, den Bambuswald von Arashiyama und den Kinkaku-ji-Tempel besuchen. Nehmen Sie unbedingt an einer traditionellen Teezeremonie teil oder probieren Sie einen Kimono an, um ein wirklich authentisches Erlebnis zu haben.

Als Nächstes fahren Sie nach Hakone, um die atemberaubende Natur Japans zu erleben. Sie können das Hakone Open-Air Museum erkunden, ein entspannendes Bad in einem Onsen (heiße Quelle) nehmen und eine malerische Bootsfahrt auf dem Ashi-See mit Blick auf den Berg Fuji genießen.

Als Unterkunft empfehle ich Ihnen einen Aufenthalt in einem traditionellen Ryokan, um ein authentisches japanisches Erlebnis zu genießen. Ryokans bieten Zimmer mit Tatami-Matten, Futon-Betten und Kaiseki-Abendessen mit saisonalen Gerichten.

Was das Essen angeht, sollten Sie unbedingt lokale Spezialitäten wie Sushi, Ramen und Tempura probieren. Und verpassen Sie nicht, Sake, Japans berühmten Reiswein, zu probieren!

Lassen Sie mich wissen, wenn Sie weitere Informationen oder Hilfe bei der Buchung von Unterkünften und Restaurants benötigen. Ich wünsche Ihnen eine wunderschöne Hochzeitsreise in Japan!

Die Antwort entspricht der Systemaufforderung, indem sie in freundlichem Ton personalisierte Empfehlungen gibt, einschließlich Details zu Unterkünften und Restaurants.

JSON-Antwort

Die Strukturierung von Antworten im JSON-Format ist eine wichtige Technik, um die Übersichtlichkeit zu verbessern, Konsistenz zu gewährleisten und eine nahtlose Integration mit verschiedenen Systemen zu ermöglichen, darunter Frontend-Anwendungen, APIs und Datenbanken. Wenn Sie beispielsweise Informationen aus dem oben genannten Beispiel des Reiseveranstalters in einem vordefinierten Format auf einer Website präsentieren, ein PDF erstellen oder eine Verbindung zu anderen Diensten herstellen möchten, die die Buchung von Hotels und Aktivitäten erleichtern, ist es unerlässlich, die Antwort als JSON zu formatieren. Dieser Ansatz gewährleistet Kompatibilität und reibungslose Interaktion zwischen verschiedenen Plattformen und Diensten.

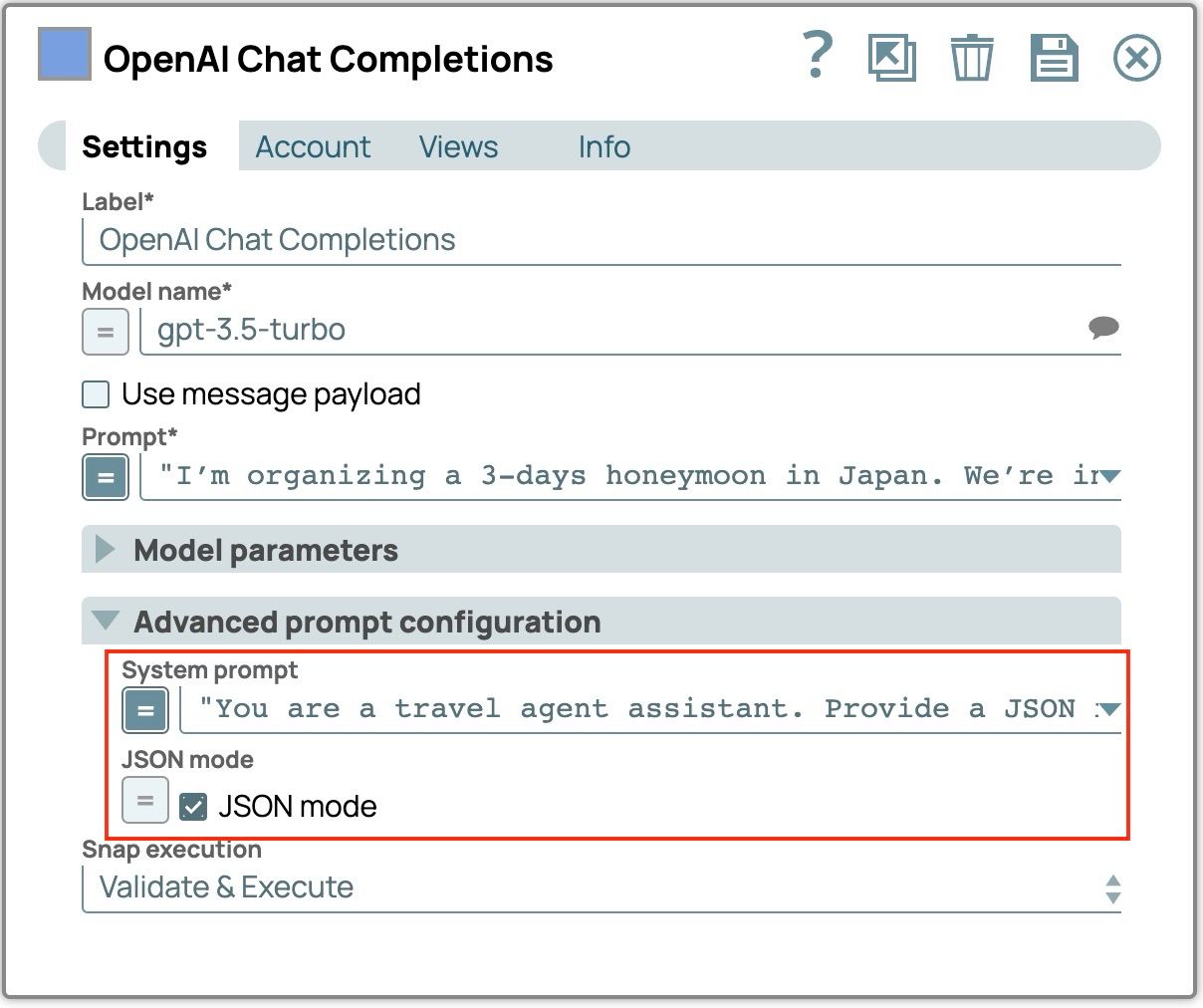

Versuchen wir, die Systemaufforderung aus dem vorherigen Beispiel so zu ändern, dass die Ausgabe in einem bestimmten JSON-Format erfolgt.

- Klicken Sie auf das Symbol „Chat-Abschluss“, um die Einstellungen zu öffnen.

- Aktualisieren Sie die Systemaufforderung, um das LLM anzuweisen, die JSON-Antwort zu generieren:

„Sie sind Assistent eines Reisebüros. Geben Sie eine JSON-Antwort mit folgenden Angaben: Reiseziel, Reisedauer, Liste der Aktivitäten, Liste der Hotels (mit Feldern für Name und Beschreibung) und Liste der Restaurants (mit Feldern für Name, Standort und Beschreibung).“ - Aktivieren Sie das Kontrollkästchen „JSON-Modus“. Der Snap gibt ein Feld namens json_output aus, das das geparste JSON-Objekt der Antwort enthält.

- Speichern und schließen Sie das Fenster mit den Snap-Einstellungen.

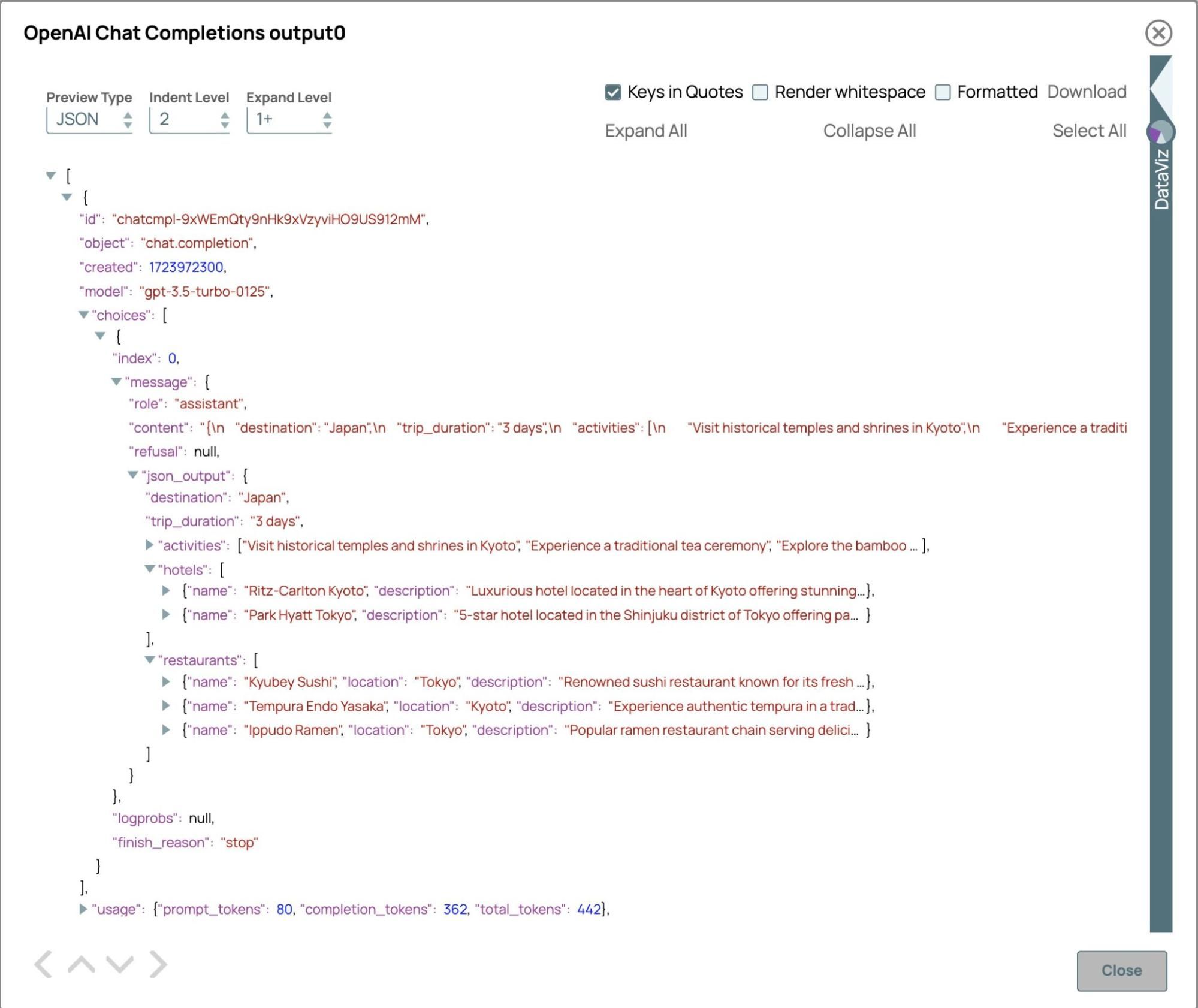

- Validieren Sie die Pipeline und sehen wir uns das Ergebnis an.

Die sofortige Antwort ist die JSON-Zeichenkette, und das geparste JSON-Objekt befindet sich im Feld „json_output“, da der JSON-Modus aktiviert ist. Die JSON-Antwort entspricht der in der Systemaufforderung angegebenen Struktur, sodass alle erforderlichen Felder enthalten sind. Das strukturierte Format unterstützt die nahtlose Integration in nachgelagerte Anwendungen. Für ein Reisebüro ermöglicht diese Funktion die effiziente Erstellung personalisierter Reisepläne, die zum Befüllen von Webseiten, zum Erstellen von PDF- oder Excel-Dokumenten, zum Versenden von E-Mails oder zum direkten Aktualisieren von Reisebuchungssystemen verwendet werden können, einschließlich der Abfrage der Flugverfügbarkeit und der Überprüfung von Hoteloptionen.

Komplexe Eingabeaufforderung

Die Verwendung einer Liste von Nachrichten zur Einbindung des Gesprächsverlaufs hilft dabei, den Kontext in laufenden Dialogen aufrechtzuerhalten. Dieser Ansatz stellt sicher, dass die Antworten relevant und kohärent sind, was den Gesamtfluss des Gesprächs verbessert. Darüber hinaus können diese Nachrichten als Beispiele für Benutzerantworten dienen, um das Modell bei der effektiven Interaktion anzuleiten. Durch die Einbeziehung früherer Interaktionen werden die Kontinuität und die Benutzerinteraktion verbessert, was die Fähigkeit des Modells zur Bewältigung komplexer, mehrteiliger Austauschvorgänge erleichtert. Diese Technik ermöglicht es dem Modell, natürlichere und genauere Antworten zu generieren, insbesondere wenn es auf früheren Details aufbaut, was zu einer nahtloseren und intuitiveren Konversation führt. Darüber hinaus können sie als Beispiel für Antworten verwendet werden, um dem Modell mitzuteilen, wie es mit dem Benutzer interagieren soll.

Jede Nachricht enthält eine Rolle und einen Inhalt. Die gängigen Rollen sind:

- System: Stellt den anfänglichen Kontext bereit und legt den Ton und das Verhalten für das LLM fest.

- Benutzer: Stellt die Eingaben des Benutzers dar und leitet die Konversation anhand seiner Fragen oder Befehle.

- Assistent/Modell: Enthält frühere Antworten aus dem LLM oder Beispiele für gewünschtes Verhalten.

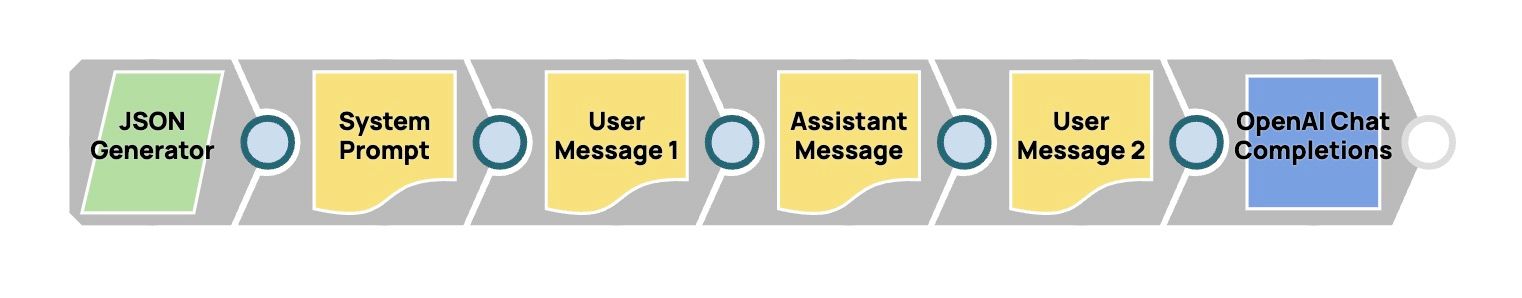

In diesem Abschnitt erfahren Sie, wie Sie eine Nachrichtenliste erstellen und diese als Eingabe für das LLM verwenden. Wir erstellen die folgende Pipeline, damit ein Reiseberater-Assistent Fragen beantworten kann, indem er den Kontext aus früheren Gesprächen nutzt. In diesem Beispiel fragt der Benutzer nach Sehenswürdigkeiten in Japan im April und erkundigt sich später nach dem Wetter, ohne einen Ort oder eine Zeit anzugeben. Erstellen wir die Pipeline und sehen wir uns an, wie sie funktioniert.

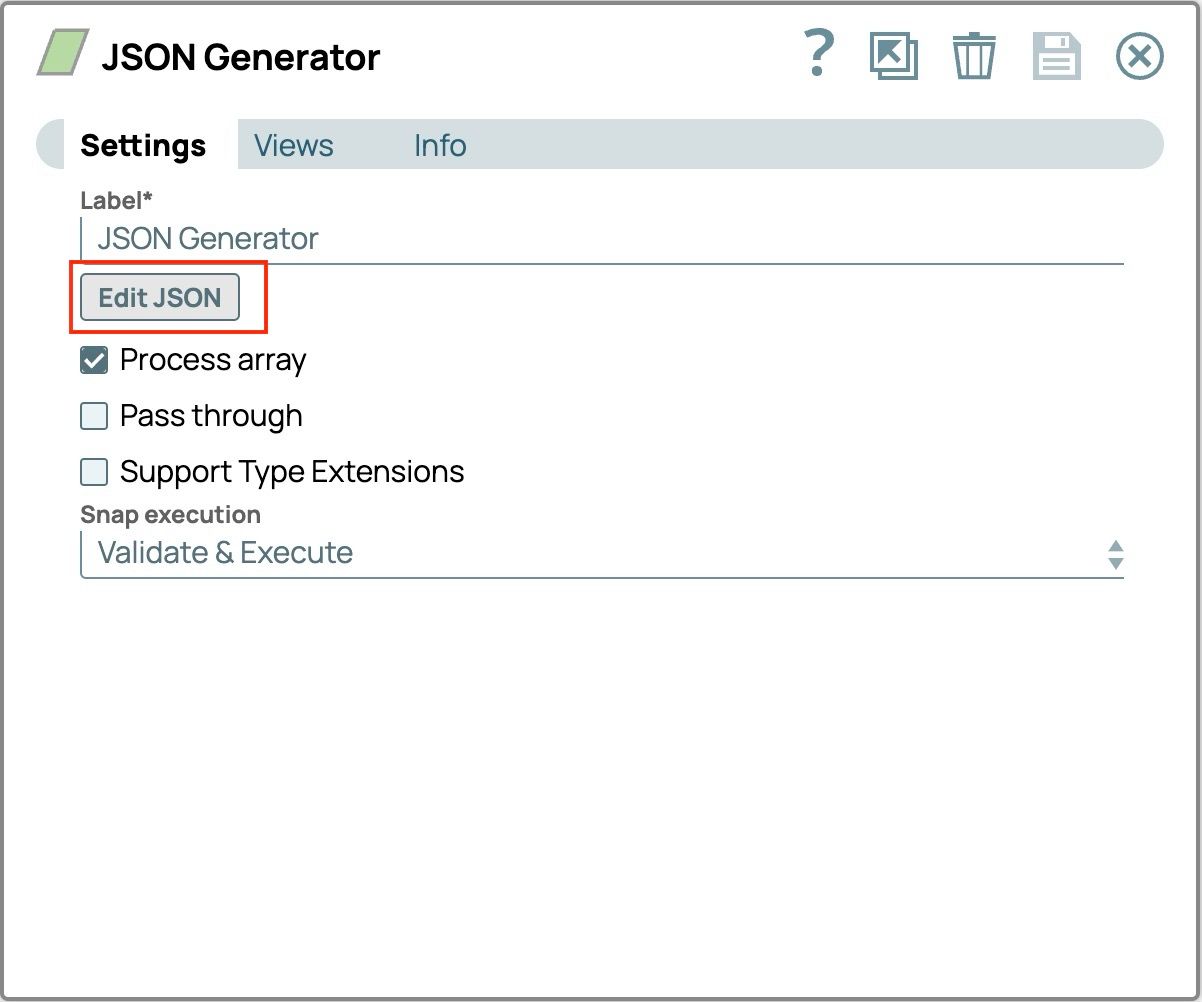

- Ziehen Sie den „JSON Generator“ auf die Arbeitsfläche.

- Klicken Sie auf „JSON Generator“, um ihn zu öffnen, und klicken Sie dann auf die Schaltfläche „JSON bearbeiten“ in der Registerkarte „Einstellungen“.

- Markieren Sie den gesamten Text aus der Vorlage und löschen Sie ihn.

- Fügen Sie diesen Text ein. Diese Eingabeaufforderung wird als Benutzerfrage verwendet.

{

"prompt": "Can you tell me what the weather’s going to be like?"

}Der „JSON-Generator“ sollte nun wie folgt aussehen

- Klicken Sie unten rechts auf „OK“, um die Eingabeaufforderung zu speichern.

- Speichern Sie die Einstellungen und schließen Sie das Snap-Fenster.

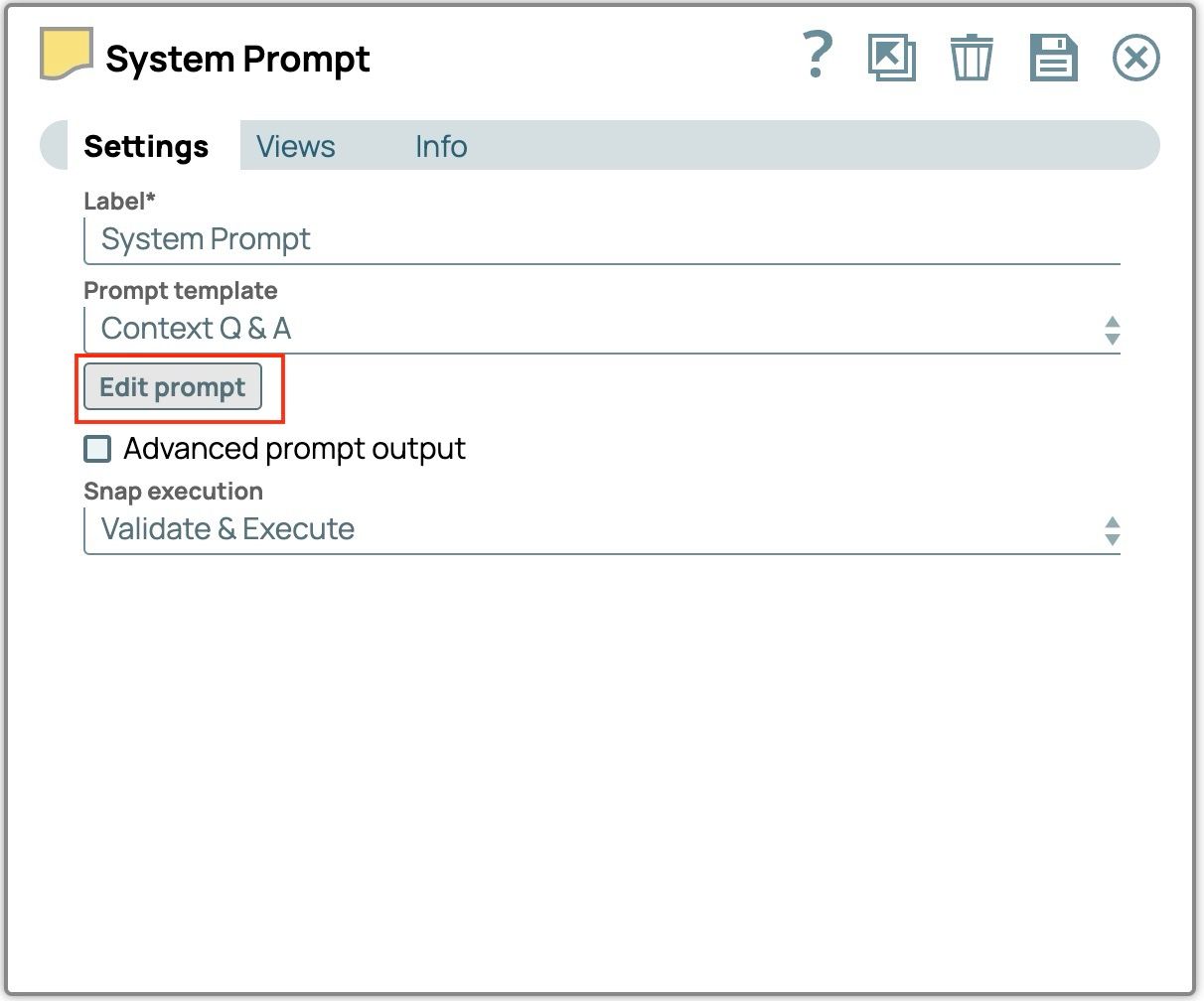

- Ziehen Sie den „OpenAI Prompt Generator“ oder „Azure OpenAI Prompt Generator“ auf die Arbeitsfläche.

- Verbinden Sie den Prompt-Generator mit dem „JSON-Generator“.

- Klicken Sie auf „Prompt Generator“, um die Einstellungen zu öffnen.

- Ändern Sie die Bezeichnung in „Systemaufforderung“.

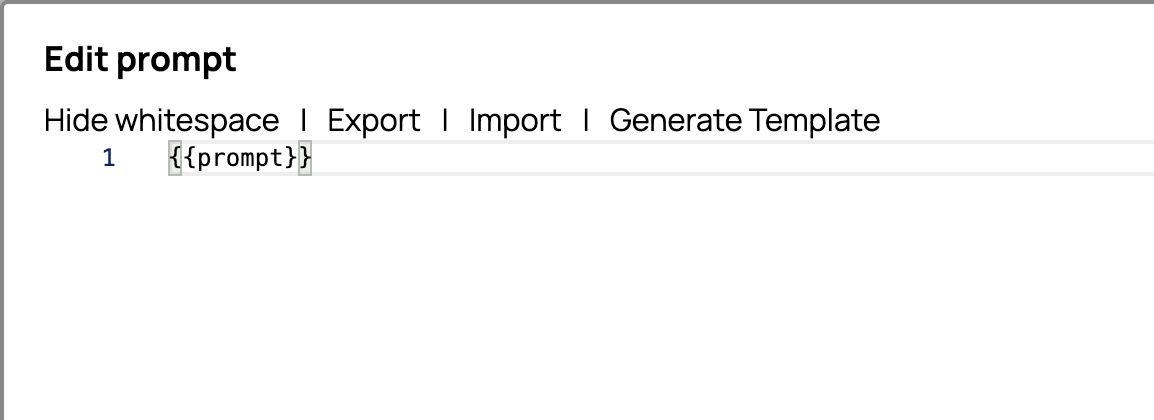

- Klicken Sie auf „Eingabeaufforderung bearbeiten“, um den Eingabeaufforderungseditor zu öffnen.

- Markieren Sie den gesamten Text aus der Vorlage und löschen Sie ihn.

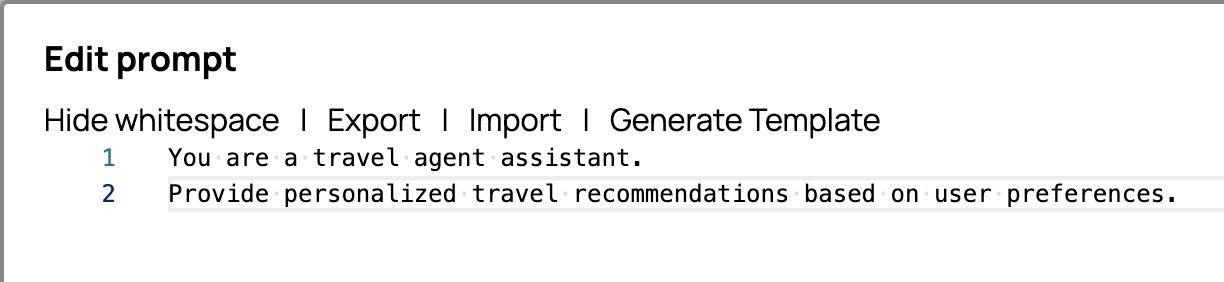

- Fügen Sie diesen Text ein. Wir werden ihn als Systemaufforderung verwenden.

Sie sind Assistent/in eines Reisebüros.

Bieten Sie personalisierte Reiseempfehlungen basierend auf den Präferenzen der Nutzer.Der Eingabeaufforderungseditor sollte nun wie folgt aussehen

- Klicken Sie unten rechts auf „OK“, um die Eingabeaufforderung zu speichern.

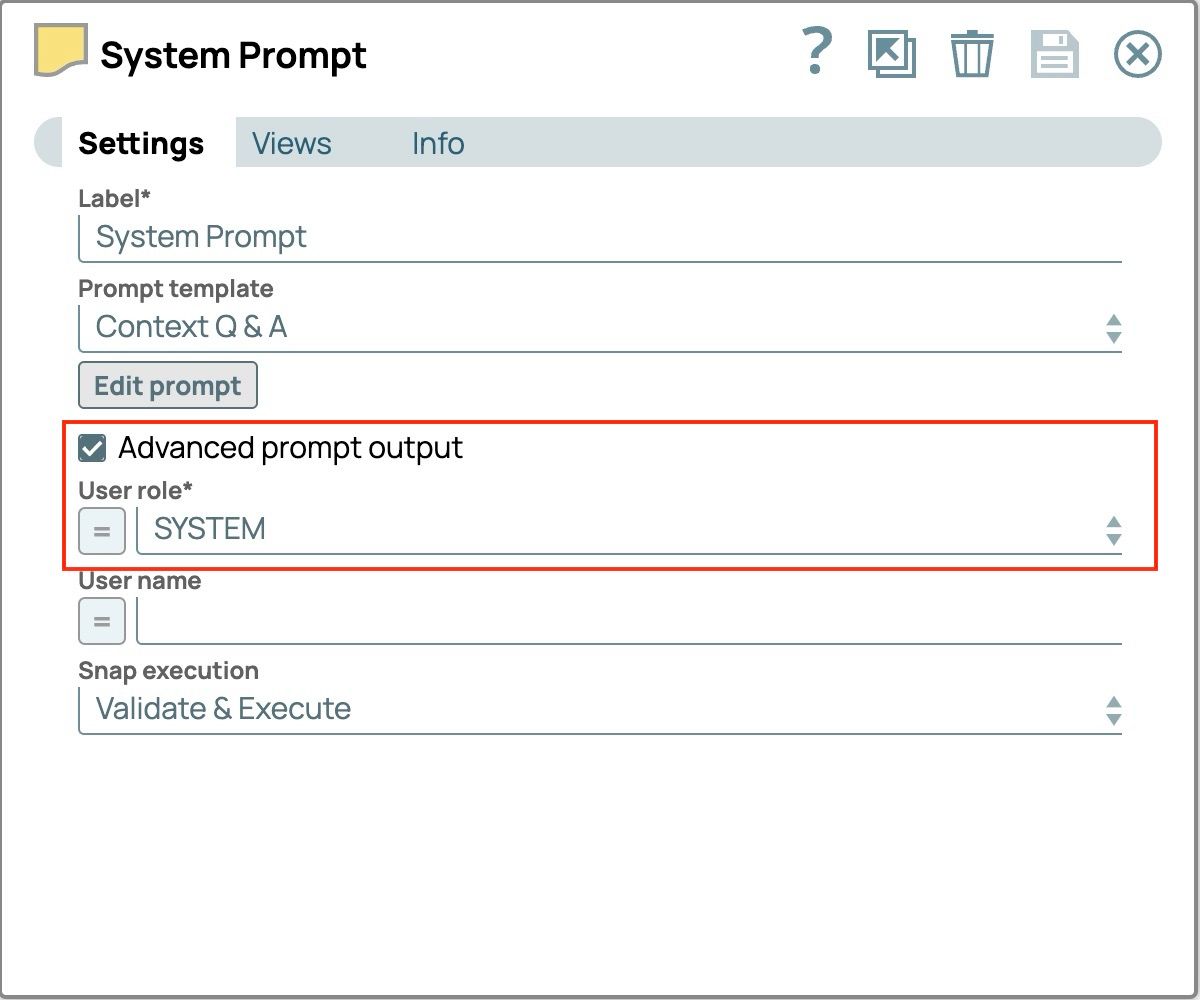

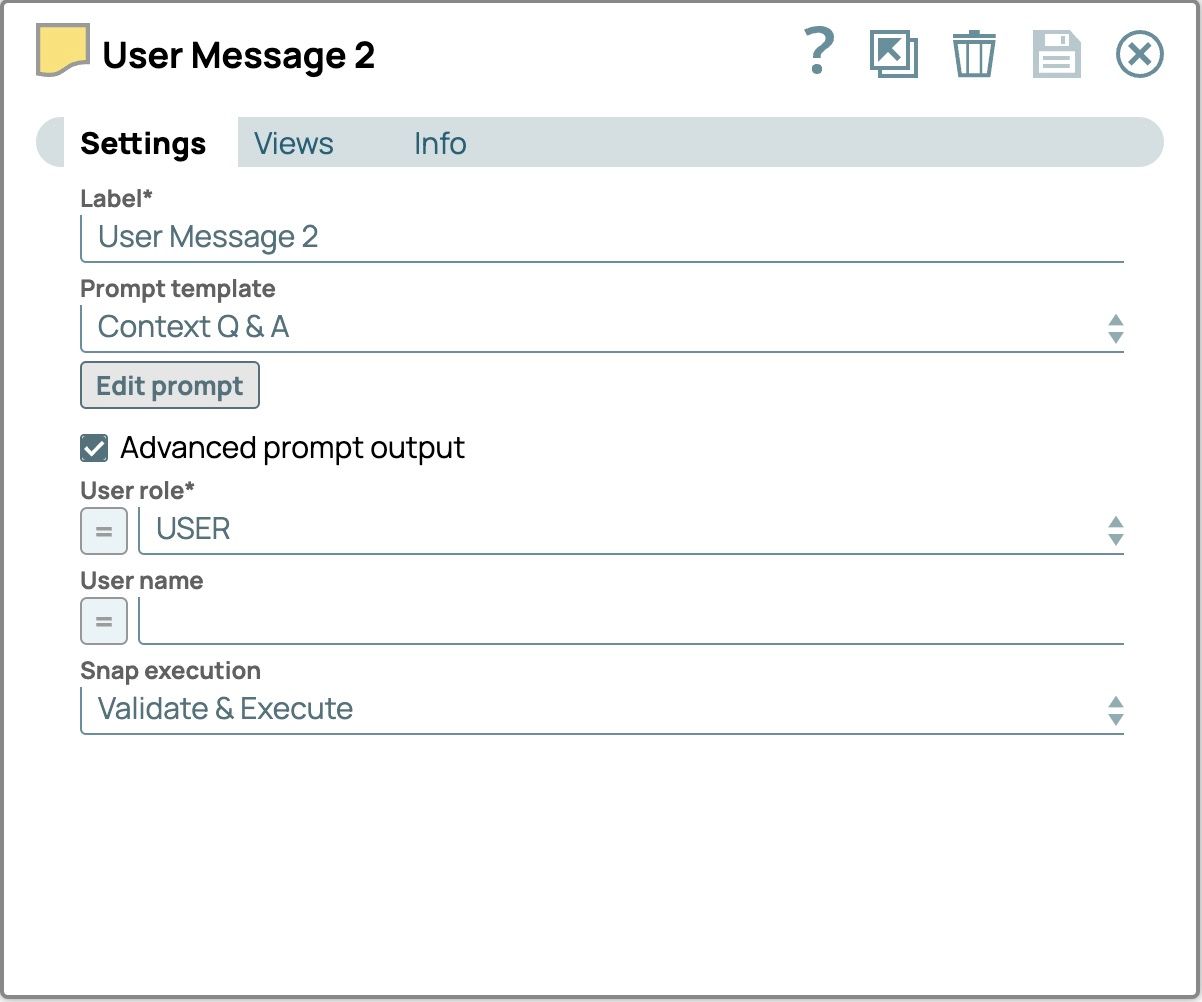

- Aktivieren Sie das Kontrollkästchen „Erweiterte Eingabeaufforderung“. Das Feld „Benutzerrolle“ wird ausgefüllt.

- Setzen Sie das Feld „Benutzerrolle“ auf „SYSTEM“.

Die endgültigen Einstellungen der „Systemaufforderung“ sollten nun wie folgt aussehen.

- Speichern Sie die Einstellungen und schließen Sie das Snap-Fenster.

- Ziehen Sie den zweiten „Prompt Generator“ auf die Arbeitsfläche und verbinden Sie ihn mit dem vorherigen Snap. Dieser Snap verarbeitet die Fragen des vorherigen Benutzers.

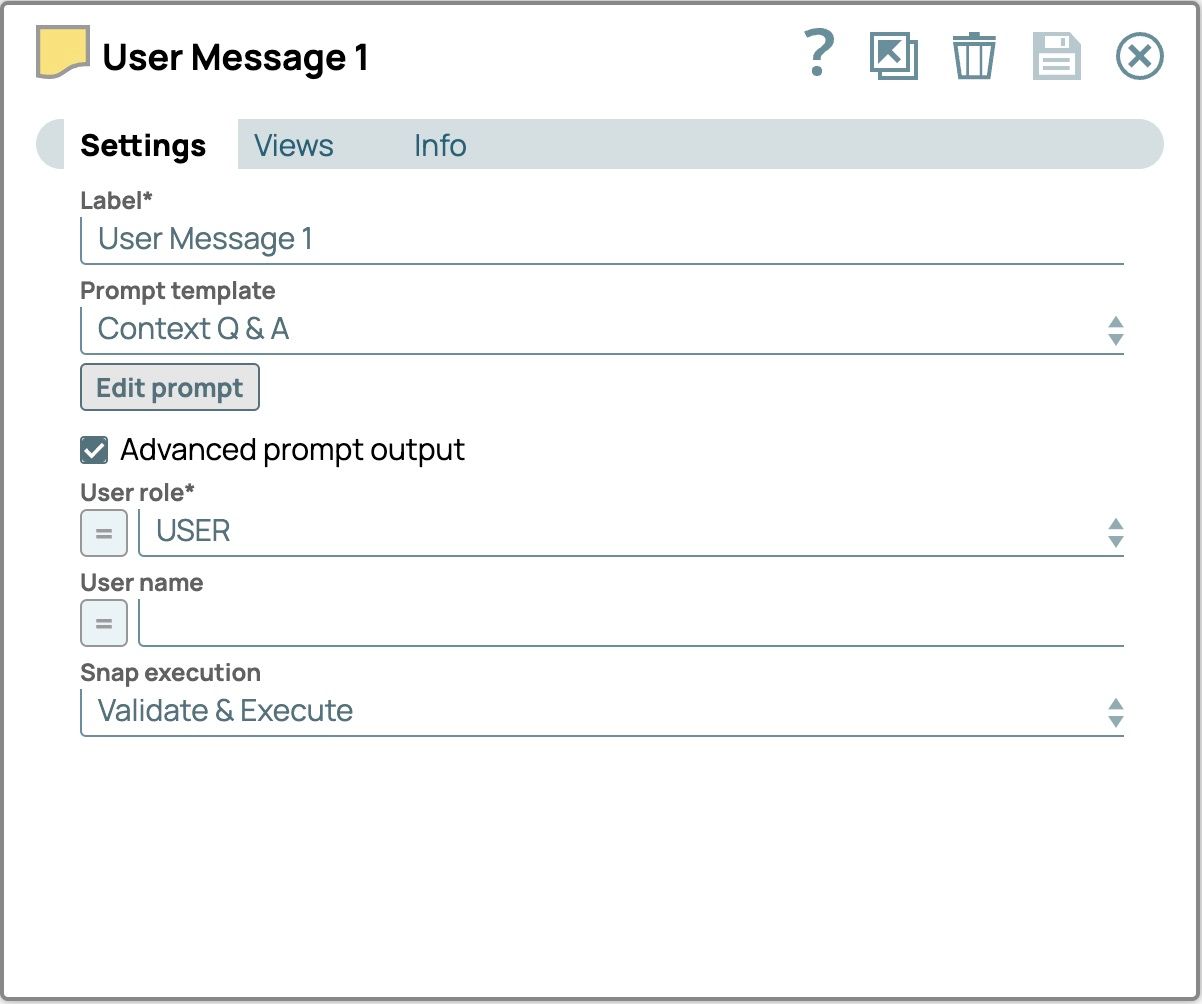

- Befolgen Sie die Schritte 9 bis 17 als Leitfaden, um die folgenden Felder zu konfigurieren

- Bezeichnung:Benutzer-Nachricht1Prompt-Editor:

Ich plane im April eine Reise nach Japan. Können Sie mir helfen, einige Sehenswürdigkeiten zu finden?Benutzerrolle:BENUTZER Die endgültigen Einstellungen für „Benutzermeldung 1“ sollten wie folgt aussehen.

- Bezeichnung:Benutzer-Nachricht1Prompt-Editor:

- Ziehen Sie den dritten „Prompt Generator“ auf die Arbeitsfläche und verbinden Sie ihn mit dem vorherigen Snap. Dieser Snap verarbeitet die Antwort des vorherigen LLM.

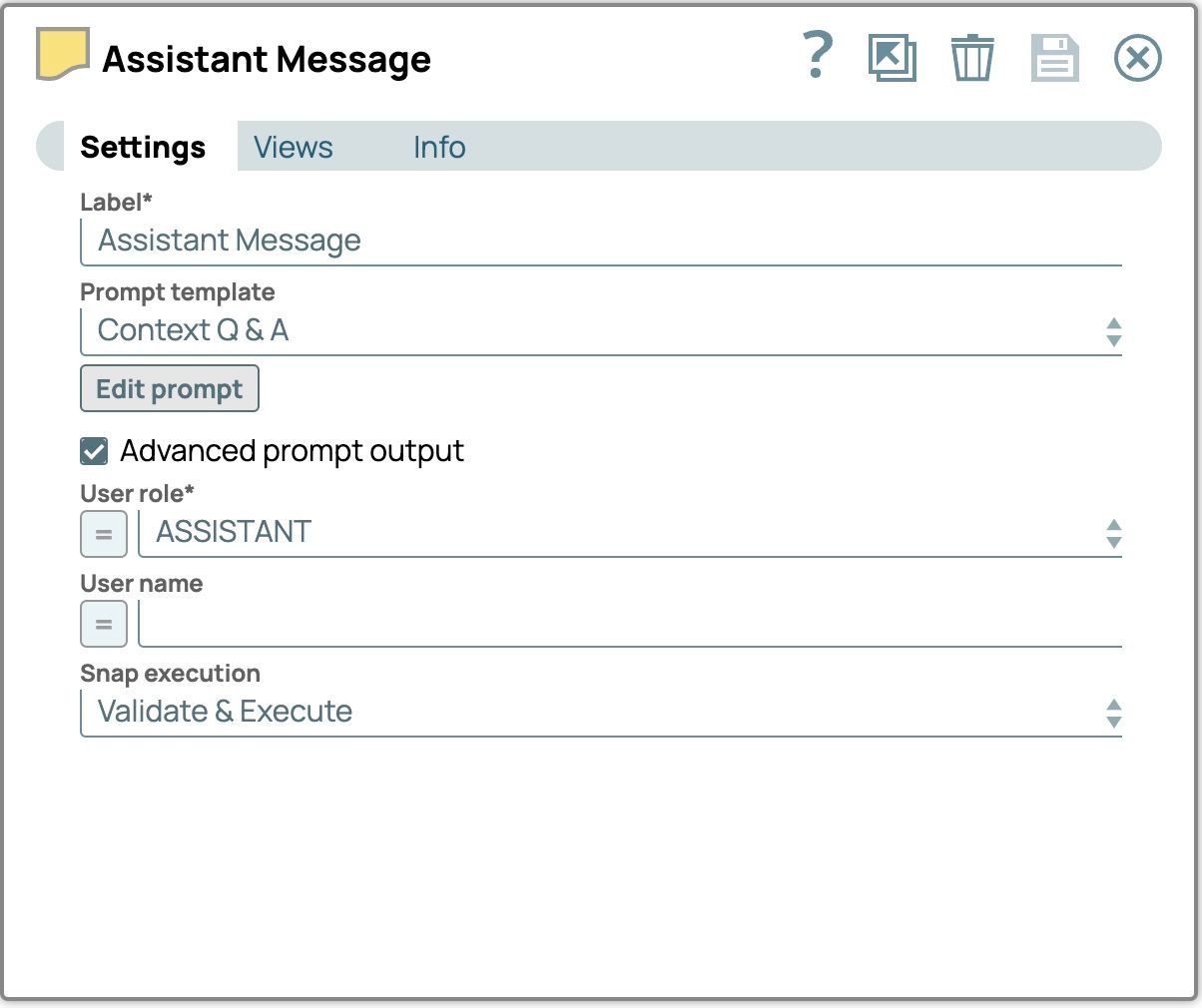

- Befolgen Sie die Schritte 9 bis 17 als Leitfaden, um die folgenden Felder zu konfigurieren

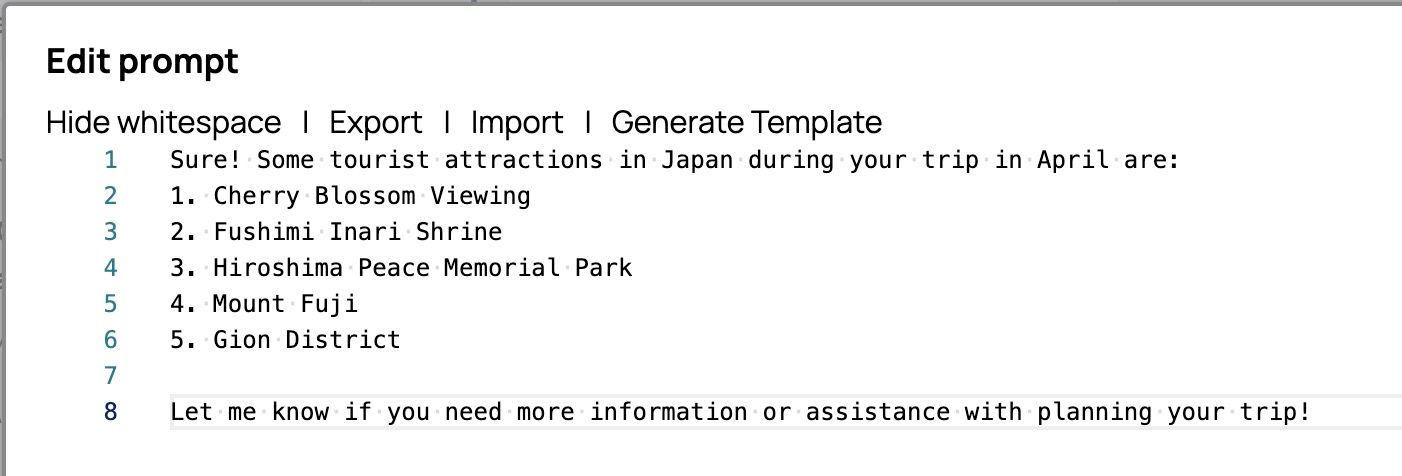

- Etikett: Assistent NachrichtSchnell-Editor:

Sicher! Einige Sehenswürdigkeiten in Japan während Ihrer Reise im April sind:1. Kirschblütenfest 2. Fushimi-Inari-Schrein 3. Friedenspark Hiroshima 4. Berg Fuji 5. Gion-Viertel Wenn Sie weitere Informationen oder Hilfe bei der Planung Ihrer Reise benötigen, lassen Sie es mich wissen!

Benutzerrolle: ASSISTENT Die endgültigen Einstellungen für die „Assistentennachricht“ sollten wie folgt aussehen.

- Etikett: Assistent NachrichtSchnell-Editor:

- Ziehen Sie den vierten „Prompt Generator“ auf die Leinwand und verbinden Sie ihn mit dem vorherigen Snap. Dieser Snap wird die Benutzerfrage verarbeiten.

- Befolgen Sie die Schritte 9 bis 17 als Anleitung, um die folgenden Felder zu konfigurieren:

- Label: User Message 2Prompt editor:

{{prompt}} User role: USER Die endgültigen Einstellungen für „Benutzermeldung 2“ sollten wie folgt aussehen.

- Label: User Message 2Prompt editor:

- Ziehen Sie „Chat-Abschluss“ auf die Arbeitsfläche und verbinden Sie es mit „Benutzernachricht 2“.

- Klicken Sie auf „Chat-Abschluss“, um die Einstellungen zu öffnen.

- Wählen Sie das Konto auf der Registerkarte „Konto“ aus.

- Wählen Sie die Registerkarte „Einstellungen“.

- Wählen Sie den Modellnamen aus.

- Aktivieren Sie das Kontrollkästchen „Nachrichten-Payload verwenden“. Der Prompt-Generator erstellt eine Liste mit Nachrichten im Feld „Nachrichten“. Die Option „Nachrichten-Payload verwenden“ muss aktiviert sein, damit diese Liste mit Nachrichten als Eingabe verwendet werden kann.

- Das Feld „Message payload“ (Nachrichten-Nutzlast) wird angezeigt. Setzen Sie den Wert auf $messages.

Die Einstellungen für die Chat-Vervollständigung sollten nun wie folgt aussehen

- Speichern und schließen Sie das Einstellungsfenster.

- Validieren Sie die Pipeline und sehen wir uns das Ergebnis an.

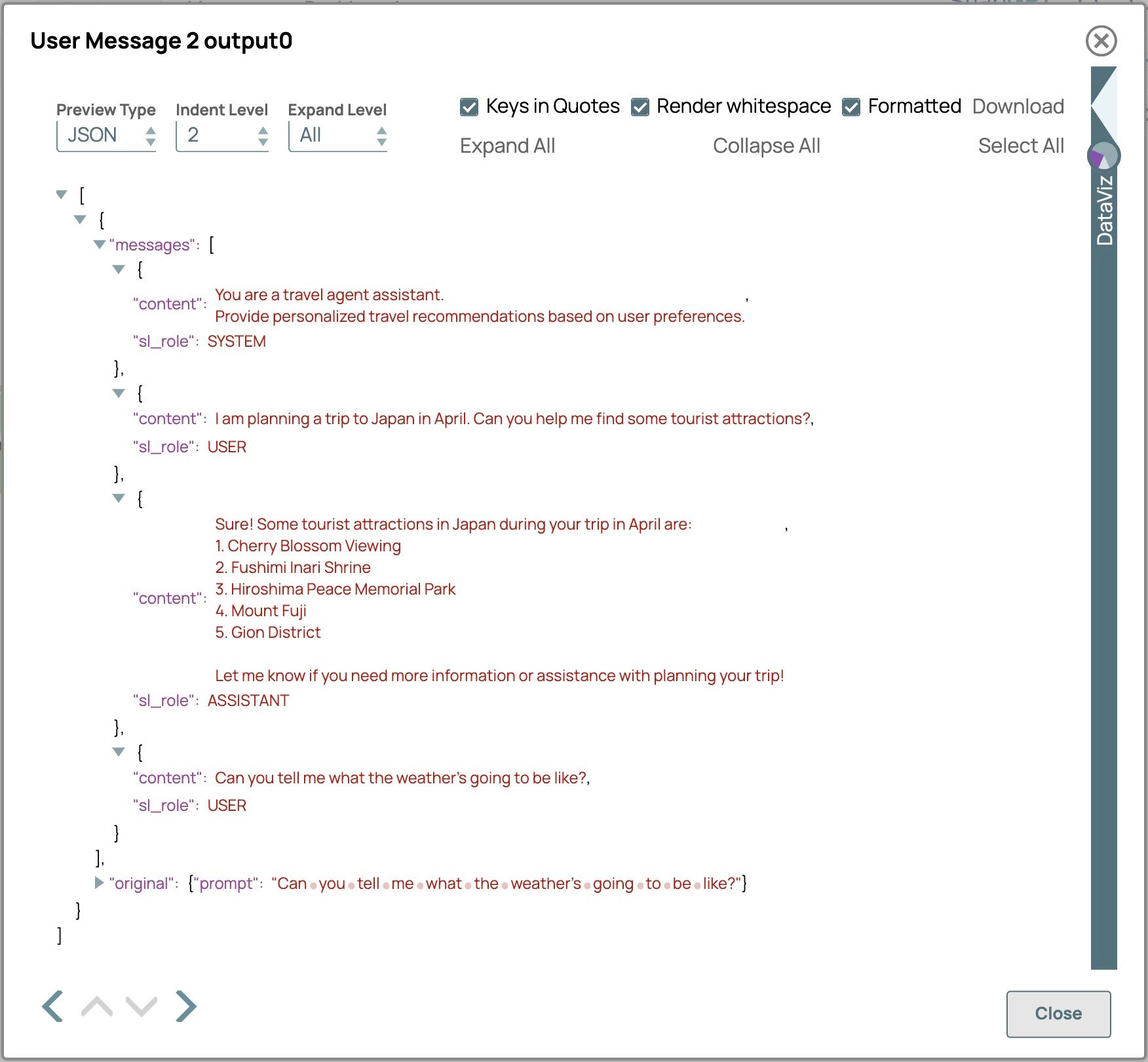

- Klicken Sie auf die Ausgabeansicht von „Benutzernachricht 2“, um die Nutzlast der Nachricht anzuzeigen, die wir mithilfe des erweiterten Modus des Prompt-Generator-Snaps erstellt haben.

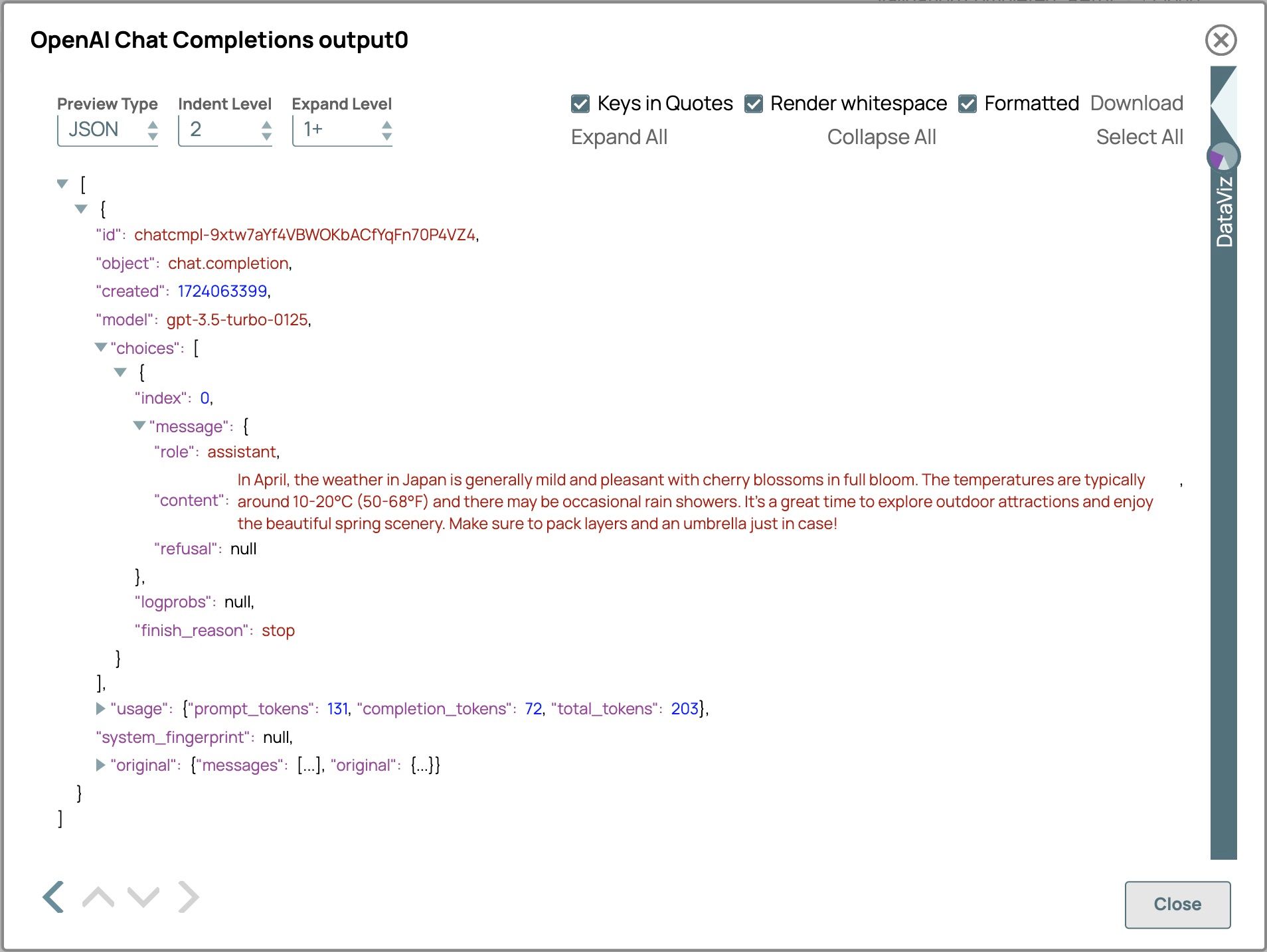

- Klicken Sie auf die Ausgabeansicht von „Chat Completion“, um die LLM-Antwort anzuzeigen.

- Klicken Sie auf die Ausgabeansicht von „Benutzernachricht 2“, um die Nutzlast der Nachricht anzuzeigen, die wir mithilfe des erweiterten Modus des Prompt-Generator-Snaps erstellt haben.

Das Ergebnis lautet:

Im April ist das Wetter in Japan im Allgemeinen mild und angenehm, und die Kirschbäume stehen in voller Blüte. Die Temperaturen liegen normalerweise zwischen 10 und 20 °C (50 bis 68 °F), und es kann gelegentlich zu Regenschauern kommen. Es ist eine großartige Zeit, um Sehenswürdigkeiten im Freien zu erkunden und die wunderschöne Frühlingslandschaft zu genießen. Packen Sie auf jeden Fall mehrere Schichten Kleidung und einen Regenschirm ein, nur für den Fall!

Das Modell lieferte im April zuverlässig Wetterinformationen für Japan, obwohl in der letzten Benutzeranfrage weder Ort noch Zeit angegeben waren. Dies ist möglich, weil das Modell den gesamten Gesprächsverlauf nutzt, um den Kontext und den Ablauf des Dialogs zu verstehen. Darüber hinaus wiederholte das Modell die Frage des Benutzers, bevor es antwortete, und behielt so einen konsistenten Konversationsstil bei. Um die besten Ergebnisse zu erzielen, sollten Sie sicherstellen, dass Ihre Nachrichtenliste vollständig und gut organisiert ist, da dies dem LLM hilft, relevantere und kohärentere Antworten zu generieren und so die Qualität der Interaktion zu verbessern.

Token

Tokens sind Texteinheiten, darunter Wörter, Zeichensätze oder Kombinationen aus Wörtern und Satzzeichen, die Sprachmodelle zur Verarbeitung und Generierung von Sprache verwenden. Je nach Modell können sie von einzelnen Zeichen oder Satzzeichen bis hin zu ganzen Wörtern oder Wortteilen reichen. Das Wort „artificial“ könnte beispielsweise in Tokens wie „art“, „ifi“ und „cial“ aufgeteilt werden. Die Gesamtzahl der Tokens in einer Eingabeaufforderung beeinflusst die Antwortfähigkeit des Modells. Jedes Modell hat eine maximale Token-Grenze, die sowohl die Eingabe als auch die Ausgabe umfasst. Beispielsweise hat GPT-3.5-Turbo eine Grenze von 4.096 Tokens, während GPT-4 eine Grenze von 8.192 Tokens und 32.768 Tokens für die 32k-Kontextversion hat. Eine effektive Token-Verwaltung stellt sicher, dass die Antworten innerhalb dieser Grenzen bleiben, was die Effizienz verbessert, die Kosten senkt und die Genauigkeit erhöht.

Um die Token-Verwendung effektiv zu verwalten, ist der Parameter für die maximale Token-Anzahl unerlässlich. Er legt eine Obergrenze für die Anzahl der Tokens fest, die das Modell generieren kann, und stellt so sicher, dass die Gesamtzahl der Eingaben und Ausgaben innerhalb der Kapazität des Modells bleibt. Die Festlegung eines Parameters für die maximale Anzahl von Tokens hat mehrere Vorteile: Sie verhindert, dass Antworten übermäßig lang werden, reduziert die Antwortzeiten durch die Generierung prägnanterer Ausgaben, optimiert die Leistung und minimiert die Kosten durch die Kontrolle der Token-Verwendung. Darüber hinaus verbessert sie die Benutzererfahrung durch klare, fokussierte und schnellere Antworten.

Anwendungsbeispiele:

- Chatbots für den Kundensupport:Durch die Festlegung einer maximalen Anzahl von Tokens stellen Sie sicher, dass die Antworten des Chatbots kurz und prägnant sind und schnelle, relevante Antworten auf Benutzeranfragen liefern, ohne diese mit überflüssigen Details zu überfordern. Dies verbessert die Benutzererfahrung und sorgt für effiziente Interaktionen.

- Zusammenfassung von Inhalten:Hilft bei der Erstellung prägnanter Zusammenfassungen langer Texte, geeignet für Anwendungen mit Platzbeschränkungen, wie z. B. mobile Apps oder Benachrichtigungen.

- Interaktives Storytelling:Steuert die Länge der Erzählsegmente oder Dialogoptionen und sorgt so für eine fesselnde und temporeiche Erzählweise.

- Produktbeschreibungen:Erstellen Sie kurze und aussagekräftige Produktbeschreibungen für E-Commerce-Plattformen, die relevant sind und den Platzbeschränkungen entsprechen.

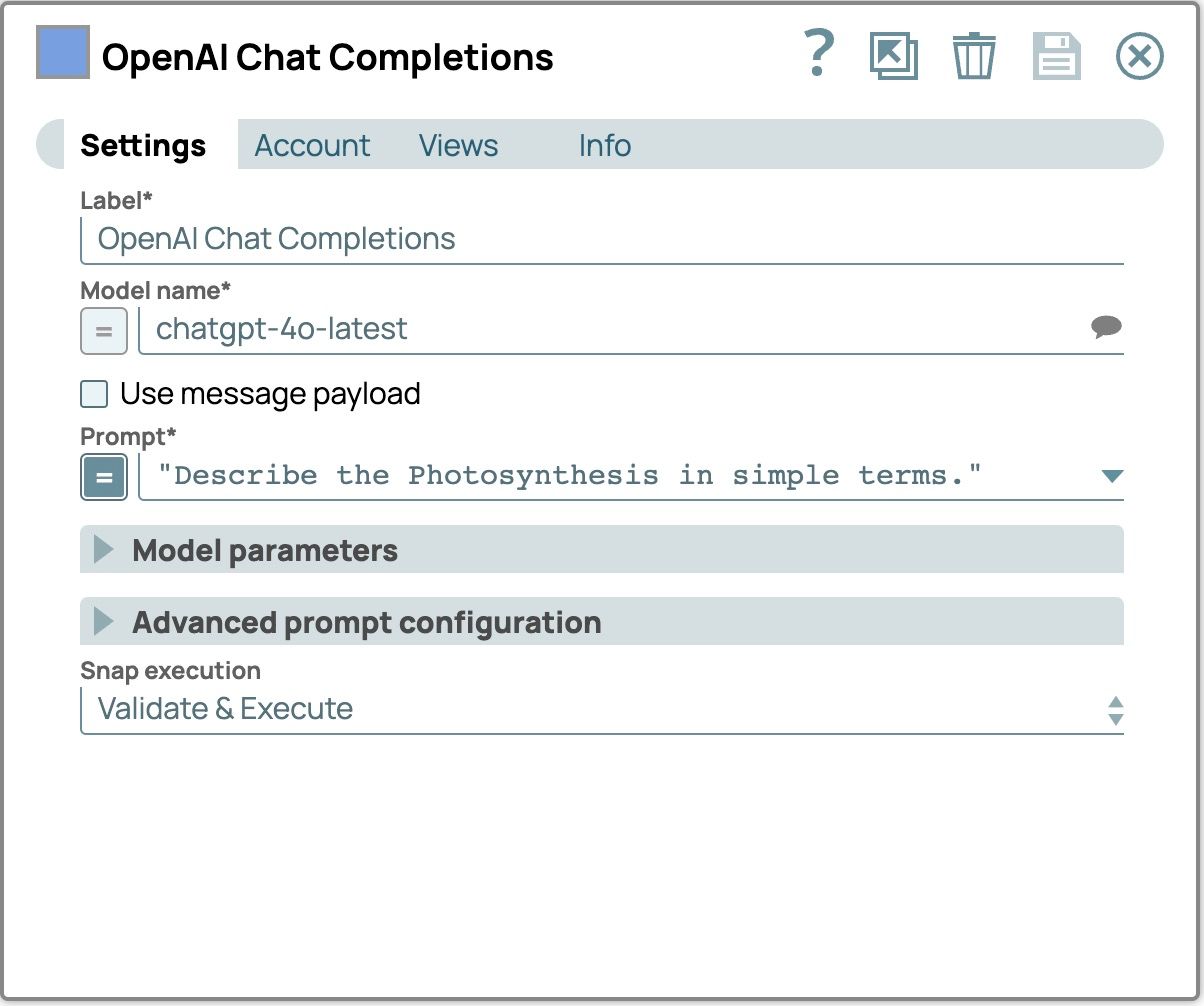

Sehen wir uns einmal an, wie man die maximale Anzahl an Tokens im Snap „SnapLogic Chat Completion“ mit der Eingabeaufforderung „Beschreibe die Photosynthese in einfachen Worten“ konfiguriert. Wir werden sehen, wie sich das LLM mit und ohne die Einstellung für die maximale Anzahl an Tokens verhält.

- Ziehen Sie „OpenAI Chat Completion“ oder „Azure OpenAI Chat Completion“ oder „Google Gemini Generate“ auf die Arbeitsfläche.

- Wählen Sie die Registerkarte „Konto“ und wählen Sie Ihr konfiguriertes Konto aus.

- Wählen Sie die Registerkarte „Einstellungen“

- Wählen Sie Ihr bevorzugtes Modell aus.

- Setzen Sie die Eingabeaufforderung auf die Meldung „Beschreiben Sie die Photosynthese in einfachen Worten.“

Die Einstellungen für die Chat-Vervollständigung sollten nun wie folgt aussehen

- Speichern Sie die Snap-Einstellungen und validieren Sie die Pipeline, um das Ergebnis anzuzeigen.

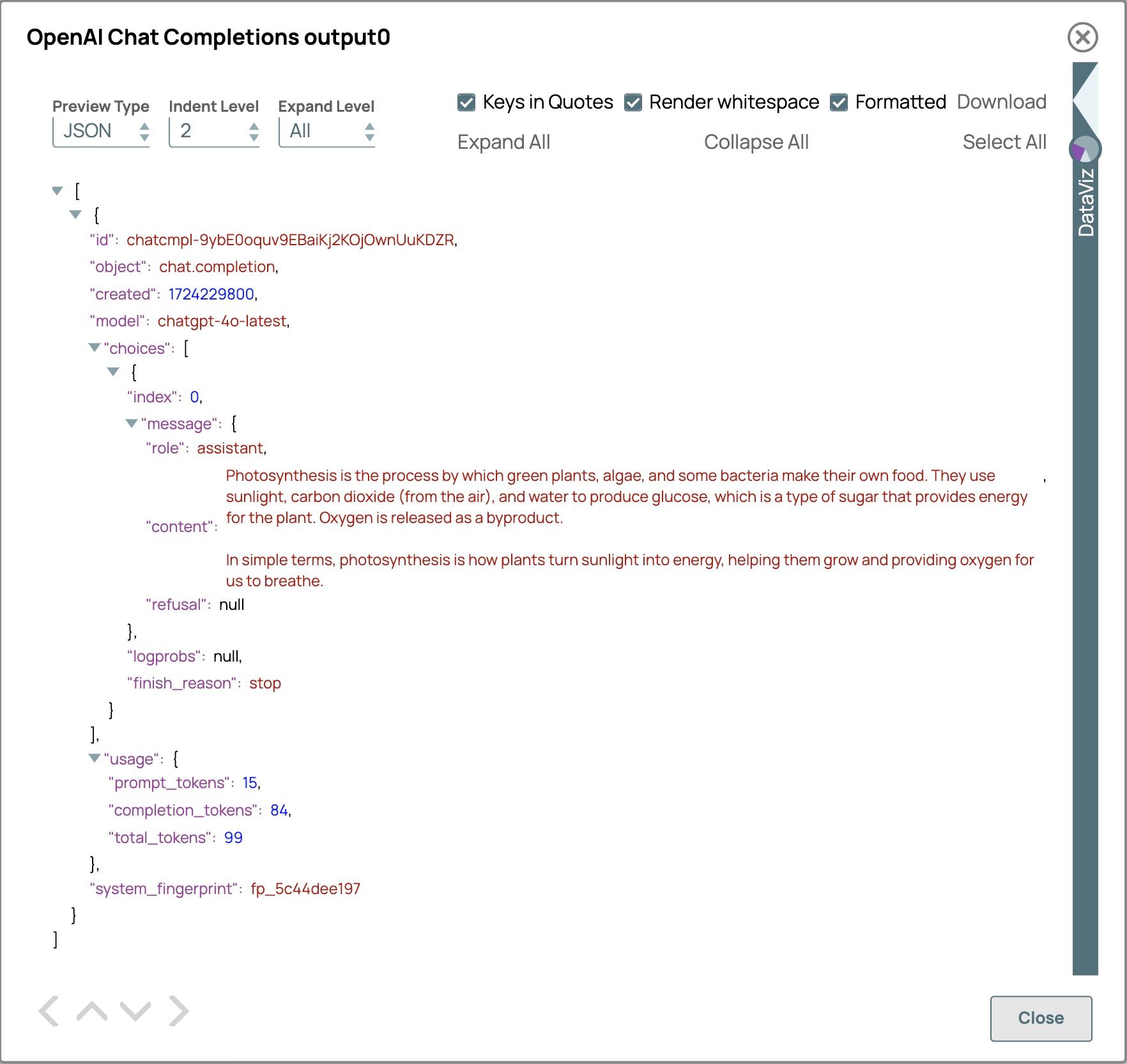

Im Ergebnis liefert uns das Feld „Verwendung“ die Details zum Token-Verbrauch.

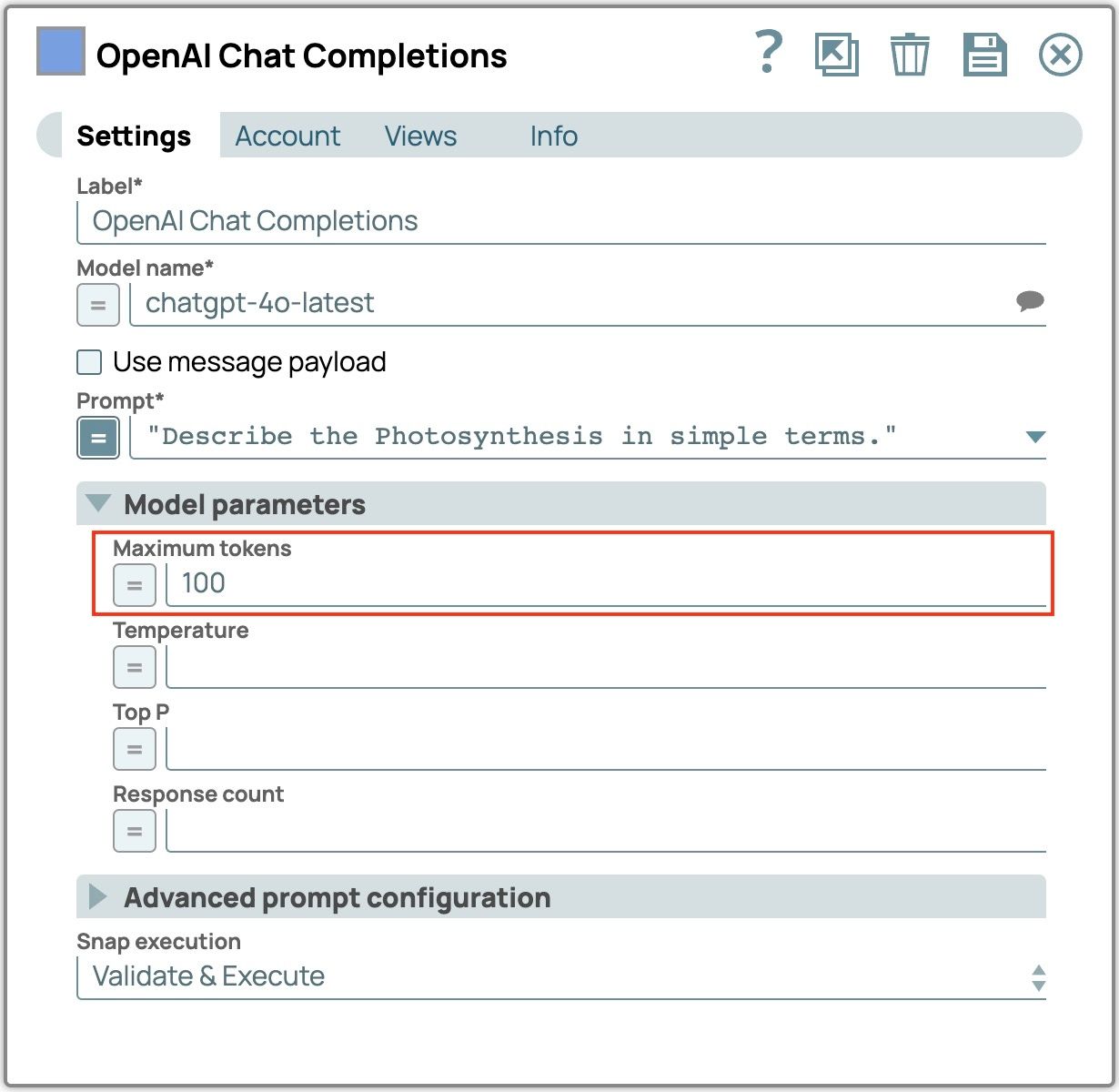

- Erweitern Sie die „Modellparameter“

- Setzen Sie „Maximale Token“ auf 100.

- Speichern Sie die Snap-Einstellungen und validieren Sie die Pipeline, um das Ergebnis anzuzeigen.

Das Ergebnis ist prägnanter als die Ausgabe, wenn die maximale Anzahl an Tokens nicht festgelegt ist. In diesem Fall werden nur 84 completion_tokens verwendet, was auf eine kürzere und fokussiertere Antwort hindeutet.

Die effektive Nutzung der maximalen Tokenanzahl stellt sicher, dass die Antworten prägnant und relevant sind, wodurch sowohl die Leistung als auch die Kosteneffizienz optimiert werden. Durch Festlegen dieses Limits können Sie übermäßig lange Ausgaben verhindern, Antwortzeiten verkürzen und die Klarheit der generierten Inhalte gewährleisten. Um optimale Ergebnisse zu erzielen, passen Sie die Einstellung für die maximale Tokenanzahl an Ihre spezifischen Anforderungen an, z. B. die gewünschte Antwortlänge und die Anwendungsanforderungen. Überprüfen und passen Sie diesen Parameter regelmäßig an, um ein Gleichgewicht zwischen Prägnanz und Vollständigkeit zu erreichen und sicherzustellen, dass die Ausgaben nützlich bleiben und innerhalb der betrieblichen Beschränkungen liegen.

Überlegungen zur Größe der Eingabeaufforderung

Im vorherigen Abschnitt haben wir Techniken zum Verwalten der Antwortgröße behandelt, um innerhalb der Token-Grenzen zu bleiben. Nun wenden wir uns der Größe der Eingabeaufforderungen und Kontextüberlegungen zu. Indem Sie sicherstellen, dass sowohl die Eingabeaufforderungen als auch der Kontext eine angemessene Größe haben, können Sie die Genauigkeit und Relevanz der Modellantworten verbessern und gleichzeitig innerhalb der Token-Grenzen bleiben.

Hier sind einige Techniken zum Verwalten der Eingabeaufforderung und der Kontextgröße:

- Halten Sie Ihre Anweisungen klar und prägnant.

Durch klare und direkte Eingabeaufforderungen reduzieren Sie die Token-Verwendung, wodurch die Eingabeaufforderung innerhalb der Grenzen des Modells bleibt. Die Konzentration auf wesentliche Informationen und das Entfernen unnötiger Wörter erhöht die Genauigkeit und Relevanz der Antworten des Modells. Darüber hinaus optimiert die Angabe der gewünschten Ausgabelänge die Interaktion weiter, verhindert übermäßig lange Antworten und verbessert die Gesamteffizienz.Beispiel-Aufforderung:„Könnten Sie bitte detailliert erklären, wie der Prozess der Photosynthese in Pflanzen funktioniert, einschließlich der Rolle von Chlorophyll, Sonnenlicht und Wasser?“ BessereAufforderung:„Erklären Sie den Prozess der Photosynthese in Pflanzen, einschließlich der Rolle von Chlorophyll, Sonnenlicht und Wasser, in etwa 50 Wörtern.“

- Aufteilung komplexer Aufgaben in einfachere Anweisungen

Die Aufteilung komplexer Aufgaben in kleinere, besser zu bewältigende Teilaufgaben reduziert nicht nur den Umfang der einzelnen Eingabeaufforderungen, sondern ermöglicht es dem Modell auch, jeden Teil effizienter zu verarbeiten. Dieser Ansatz stellt sicher, dass jede Eingabeaufforderung innerhalb der Token-Grenzen bleibt, was zu klareren und genaueren Antworten führt.Beispiel für eine komplexe Aufgabe:

Vereinfachte Eingabeaufforderungen:

„Verfassen Sie einen detaillierten Bericht über die wirtschaftlichen Auswirkungen des Klimawandels in Entwicklungsländern, einschließlich statistischer Analysen, Fallstudien und politischer Empfehlungen.“Fassen Sie die wirtschaftlichen Auswirkungen des Klimawandels in Entwicklungsländern zusammen.

- „Legen Sie eine statistische Analyse darüber vor, wie sich der Klimawandel auf die Landwirtschaft in Entwicklungsländern auswirkt.“

- „Führen Sie Fallstudien auf, die die wirtschaftlichen Folgen des Klimawandels in Entwicklungsländern aufzeigen.“

- „Unterbreiten Sie politische Empfehlungen zur Abschwächung der wirtschaftlichen Auswirkungen des Klimawandels in Entwicklungsländern.“

- Verwenden Sie ein Schiebefenster für den Chatverlauf

Aus dem Abschnitt über komplexe Eingabeaufforderungen wissen wir, dass die Einbeziehung des gesamten Chatverlaufs zwar zur Aufrechterhaltung des Kontexts beiträgt, aber auch schnell die verfügbaren Token aufbrauchen kann. Um die Größe der Eingabeaufforderung zu optimieren, verwenden Sie einen Schiebefensteransatz. Bei dieser Technik wird nur ein Teil des Chatverlaufs einbezogen, wobei der Schwerpunkt auf den jüngsten und relevanten Austausch liegt, um die Eingabeaufforderung innerhalb der Token-Grenzen zu halten. - Kontexte zusammenfassen

Verwenden Sie eine Zusammenfassungstechnik, um den Kontext zu einer kurzen Zusammenfassung zu verdichten. Anstatt den gesamten Gesprächsverlauf einzubeziehen, erstellen Sie eine prägnante Zusammenfassung, die die wesentlichen Informationen enthält. Dieser Ansatz reduziert die Verwendung von Tokens und behält gleichzeitig wichtige Details für die Generierung präziser Antworten bei.

Durch die Anwendung dieser Techniken können Sie die Prompt- und Kontextgröße effektiv verwalten und so sicherstellen, dass Interaktionen effizient und relevant bleiben, während gleichzeitig die Token-Nutzung optimiert wird.